Dzisiaj będzie dużo o modelach AI…. ale to jak na świecie, bo jeśli jesteście „z internetów” to nazwę ChatGPT pewnie Wam się o uszy obiła. Będzie też o Monolitach (i to w dwóch różnych kontekstach).

1. Galactica, Cicero, pix2pix, ChatGPT – najgorętszy tydzień ever w historii modeli AI?

Zwykle, kiedy informujemy o modelach AI to w kontekście tego, jakie robią one piorunujące wrażenie. Trzeba jednak szczerze sobie powiedzieć, że historycznie bywało z tym różnie. Za jedną z najbardziej spektakularnych porażek należy uznać chyba Tay od Microsoft – chatbota, który żył sobie na Twitterze i uczył się ludzkich zachowań z tej platformy. Jeżeli użycie zwrotów „nauka ludzkich zachowań” i „Twitter” w jednym zdaniu wzbudza u Was pewne obawy to gratulujemy – trafiliście.

Tay szybko wchłonęła najbardziej skrajne zachowania, zaczęła wychwalać Hitlera (jak Kayne West) i ogólnie była wielką porażką wizerunkową dla firmy matki, która szybko się musiała z projektu wycofać. Od tego czasu wszyscy raczej dość dobrze się pilnują, aby tego typu eksperymenty nie wybuchały w twarz i podobnych sytuacji mamy znacznie mniej – czasem jednak coś się jeszcze „prześlizgnie”. Tym razem przydarzyło się to Facebookowi.

Firma stworzyła model, który nazwała Galactica. Przeznaczony był (emfaza celowa) dla świata nauki, wytrenowany na 48 milionach artykułów naukowych, stron internetowych, podręczników, notatek z wykładów i encyklopedii. Miał on pomagać akademikom poprzez streszczanie prac, rozwiązywanie problemów matematycznych, pisania kodu naukowego, czy anotowania cząsteczek i białek. Całość przetrwała 3 dni, ponieważ zaraz po premierze okazało się, że mimo posiadania łatki „naukowości”, model „halucynuje” i generuje niesprawdzone informacje. Dodatkowo, fakt, że przylepiona jest mu łatka „rzetelnego źródła” został przez społeczność naukową uznany za szalenie niebezpieczny. Dlatego też szybko się z tego „dema” (jak komunikował PR Mety) wycofano. Całą sprawę świetnie opisuje MIT Technology Review.

Meta ogólnie nie ma ostatnio najlepszej prasy, ale to nie znaczy, że firma jest jakimś anty-midasem. W dalszym ciągu jest nam w stanie pokazać wiele imponujących projektów. Jako fan planszówek zbieram szczenę z podłogi widząc, jak coraz więcej z najbardziej skomplikowanych gier jest wręcz niszczone przez AI. Zaczęło się od szachów (jeśli jesteście ciekawi historii pojedynku Deep Blue z Kasparovem, mam dla Was 2h dokument w temacie), potem było Go, ale powoli dotyka to też coraz więcej nowoczesnych tytułów. Tym razem padło na Diplomacy – grę, która już od lata 60-tych uchodzi za dość dobrze modelującą złożoność relacji międzynarodowych, oczywiście w uproszczonej formie. 360 minut na pojedynczą rozgrywkę, jak to podaje Board Game Geek robi wrażenie. Okazuje się, że nowy model – Cicero – stworzony przez Mete radzi sobie z „ogrywaniem” w Diplomacy nawet najbardziej zaawansowanych ludzkich graczy.

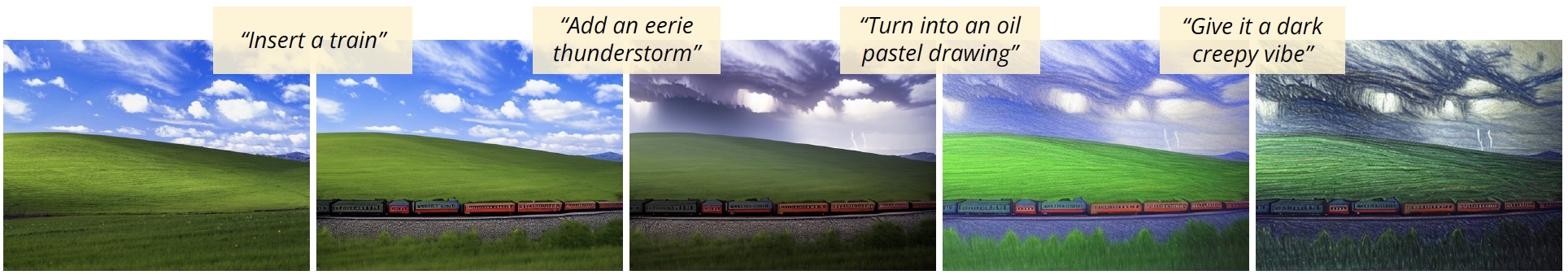

To jednak nie koniec, ponieważ Uniwersytet Kalifornijski powoli spełnia moje marzenia jeśli chodzi o elastyczność generowania obrazów przez AI. Ich najnowszy model, pix2pix, rozwiązuje bowiem największą do tej pory wadę – brak możliwości bardziej iteracyjnego podejścia do procesu twórczego. O ile bowiem generowanie treści „od zera”, czy nawet tak zwany in-painting (dogenerowywanie brakujących fragmentów obrazu) działają super, to tak naprawdę przyznam, że często – tworząc takie podwaliny – to ja jeszcze nie do końca jestem pewien, co bym chciał uzyskać. Moc pix2pix polega na tym, że pozwala zadawać polecenia w kontekście danego na wejściu obrazu. Całość brzmi jak dobrze znany Style Transfer, ale tak naprawdę sposób pracy zbliżony jest do tej z ludzkim grafikiem. Zresztą zobaczcie sami:

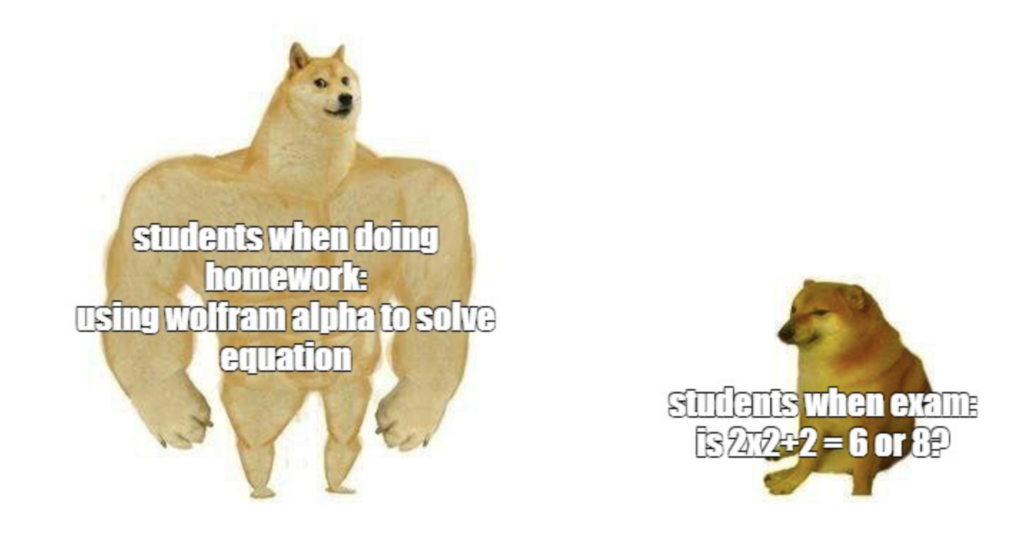

No dobra, ale wszystkie pozostałe rzeczy powyżej to czyste ciekawostki w porównaniu do tego, co pokazało OpenAI pokazało. Po pierwsze, wypuściło nowy model GPT-3 text-davinci-003, który niektórzy komentatorzy w necie określają jako GPT-3.5. Całość potrafi generować dłuższe, bardziej złożone teksty, o poziomie zbliżonym do np. akademickich rozprawek. Na razie mamy do czynienia jeszcze ciągle z tekstami nie posiadającymi jakiegoś unikalnego, autorskiego stylu, ale pracę nad „style transfer” dla tekstów też już trwają, więc to pewnie kwestia czasu. Już dziś pojawiają się głosy, że wiele szkolnych zadań domowych jest martwa – uczniowie mają dostęp do takiej klasy narzędzi, że w zasadzie większość prac mogą sobie wygenerować.

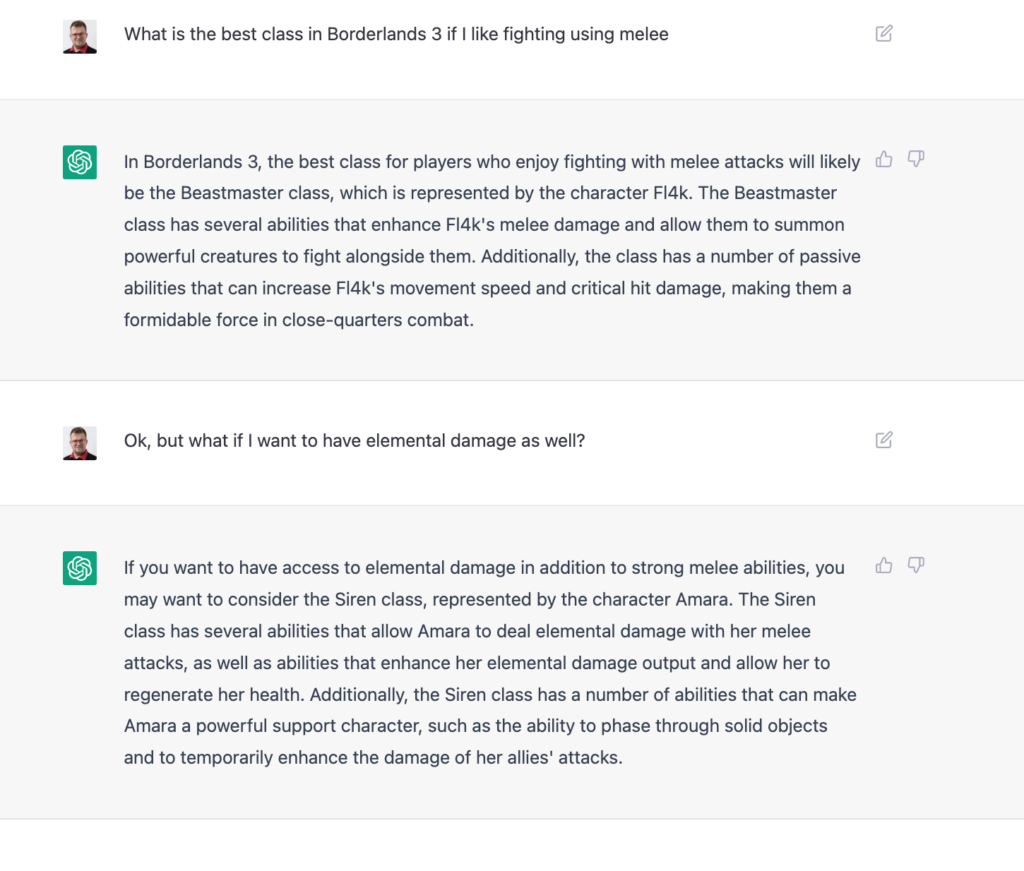

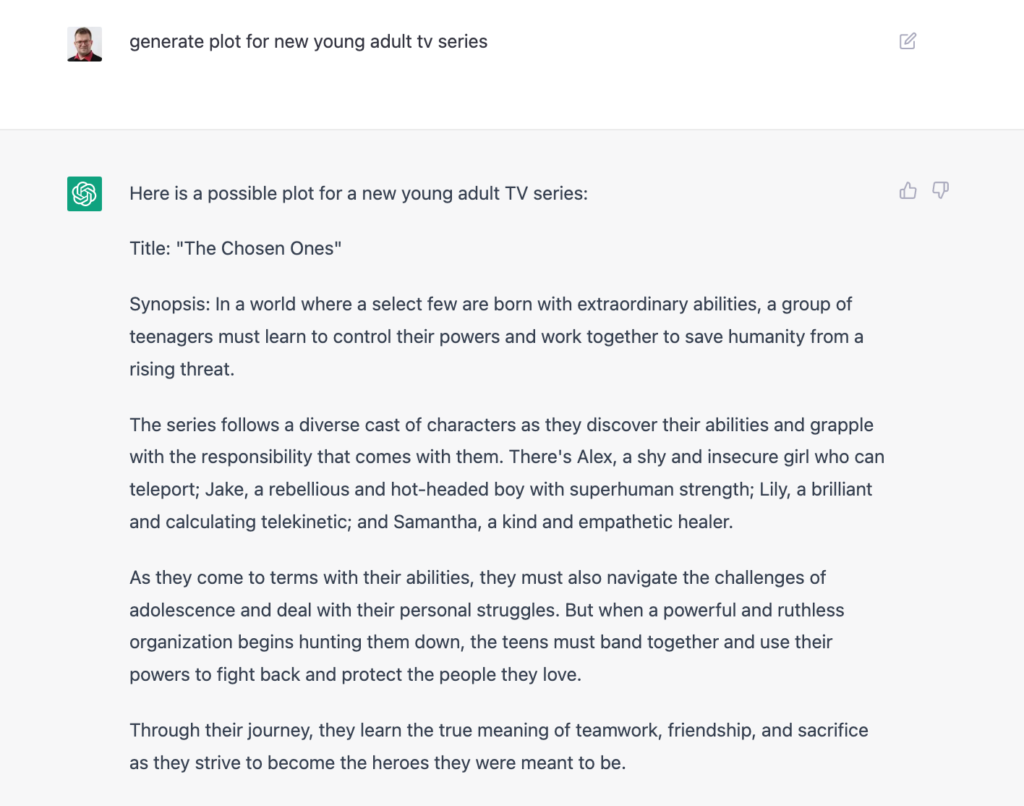

Ale tak naprawdę to dopiero ChatGPT rozwalił nam wszystkim mózgi, a internet oszalał jak po premierze Stable Diffusion. Mówimy tutaj bowiem o najbardziej zaawansowanym chatbocie ever, robiącym prawdziwe cuda. Przykłady znajdziecie w poniższym wątku:

Ja też się trochę pobawiłem i cóż… jestem pod wrażeniem:

Skurczybyk jest dobry…

Niektórzy twierdzą, że po raz pierwszy w historii Google naprawdę ma się kogo bać.

Zresztą, co ja się będę produkował, naprodukował się już wspominany przeze mnie tydzień temu newsletter The Algorithmic Bridge, który przygotował najbardziej moim zdaniem przystępne wprowadzenie do ChatGPT. AI przez lata było większym „hajpem” niż czymś użytecznym, ale w 2022 OpenAI udowodnił, że „błogosławieni, którzy nie widzieli, a uwierzyli”. Prawdą jest, że ChatGPT też potrafi robić kiksy jak wspomniana Galactica, ale kiedy mu się uda coś zrobić dobrze, to potrafi wybić z butów. Zresztą, każdy może spróbować, bo bot dostępny jest pod adresem chat.openai.com

Źródła

- Why Meta’s latest large language model survived only three days online

- Twitter taught Microsoft’s AI chatbot to be a racist asshole in less than a day

- text-davinci-003

- CICERO: An AI agent that negotiates, persuades, and cooperates with people

- ChatGPT

- pix2pix

- ChatGPT Is the World’s Best Chatbot

Zainstaluj teraz i czytaj tylko dobre teksty!

2. Glorious Monolith (kontr)atakuje

No dobra, poszybowaliśmy w przestworzach, ale chciałbym teraz wrócić na ziemię i poruszyć przynajmniej jeszcze jeden temat. Mieliśmy Czarny Piątek i pomimo recesji bite były rekordy zakupowe. Taki Shopify zdecydowało się podzielić swoimi wynikami, wzbudzając przy okazji trochę szumu w necie. No bo powiedzmy sobie szczerze, 1,27 miliona requestów na sekundę czy 3 Terabajty przesyłanych danych na minutę muszą po prostu działać na wyobraźnie.

Liczby robią wrażenie, zwłaszcza, że Shopify jest znany z dwóch wyborów technologicznych. Po pierwsze, jest to głównie Ruby Shop, używający Railsów. Po drugie, ich aplikacja jest monolitem, który mimo tego jest w stanie udźwignąć powyższy ruch. W związku z tym w internecie na nowo zagorzała dyskusja, która z architektur jest najlepsza – przykłady znajdziecie na Reddicie czy na Twitterze. Aczkolwiek, czy można nazwać Monolitem coś, co ma Kafkę, to ja się osobiście trochę zastanawiam.

Gorącą atmosferę dyskusji podkręca dodatkowo Elon Musk. Czy zdarza Wam się, że Wasz szef przychodzi z jakimś genialnym – z jego punktu widzenia – pomysłem, jeśli chodzi o architekturę systemu, którego nie pisał? To pewnie rozumiecie, że publiczne ranty Elona o mikroserwisach, które są „nikomu niepotrzebne”, wzbudzały i śmiech, i grozę zarazem. Musk dopiął jednak swego i obwieścił sukces:

Zweryfikować twierdzenia jest trudno, bo nie wiemy co tak naprawdę zmieniło się pod kątem architektury systemu (może po prostu brak reklamodawców odciążył system #pdk), ale dzięki takim ruchom Twitter nie przestaje znikać z przestrzeni zainteresowania inżynierskiego świata. A że według wielu komentatorów rzeczywiście Twitter działa szybciej (aczkolwiek ja bym chciał na to jakieś empiryczne dowody), to fani monolitu dostali nieco amunicji do ręki.

To jak już jesteśmy przy temacie Twittera, to największym zaskoczeniem dla wszystkich naokoło jest fakt, że organizacja w dalszym ciągu – mimo zwolnień i chaosu – działa. Czy zatem racje mieli Ci, którzy mówili, że Twitter był przerośnięty jako organizacja? Możliwe, ale na pewno był też po prostu dojrzały pod względem praktyk inżynierskich. Bardzo dużo mówi się o tym, że sukces Twittera (w znaczeniu – że przetrwał ostatnie roszady i dalej funkcjonuje) to tak naprawdę sukces podejścia Site-Reliability Engineering, które było popularne w firmie. Temu tematowi poświęcone było przynajmniej dwie trendujące w sieci publikacje: Why Twitter Didn’t Go Down: From a Real Twitter SRE oraz Will Twitter Infrastructure Go Down?, dlatego jeśli jesteście ciekawi detali, polecam którąkolwiek z nich. Dodatkowo, tak zwany SRE Book od Google pozostaje jedną z moich ulubionych pozycji dotyczących inżynierii oprogramowania, a że jest dostępny dla wszystkich za darmo, to po prostu radzę spróbować. Jest to najlepsze źródło, jeśli chcecie się dowiedzieć, co tak naprawdę to całe SRE wnosi do dobrych praktyk naszej branży.

Ciekawe, kiedy Elon znudzi się Twitterem – w końcu jego Neuralink zapowiada, że już niedługo zacznie testy na ludziach.

Źródła

- Reddit: Shopify monolith served 1.27 Million requests per second during Black Friday

- Why Twitter Didn’t Go Down: From a Real Twitter SRE

- Will Twitter Infrastructure Go Down?

Zainstaluj teraz i czytaj tylko dobre teksty!

Bonus: Rozpoczął się Advent of Code

Advent of Code to wydarzenie w ramach którego codziennie o 6 rano czasu polskiego od 1 do 25 grudnia publikowane są krótkie programistyczne zagadki. Tegoroczna edycja jest już szóstą i jeśli jesteście ciekawi jak to wyglądało w poprzednich to możecie sprawdzić to tutaj.

Każda łamigłówka podzielona jest na 2 etapy i za rozwiązanie każdego z nich użytkownik nagradzany jest gwiazdką. Zagadki nie mają ograniczeń dotyczących języka programowania, testów czy współbieżności – podobnie jak na studiach liczy się tylko końcowy wynik (i znam osoby, które w zeszłym roku rozwiązały niektóre zagadki przy pomocy Wolfram Alfa). Nie oznacza to, że wydajność nie jest ważna – zazwyczaj naiwne rozwiązania liczą się od kilku godzin do nawet kilku dni (a nic nie boli bardziej niż błąd rzucony po kilku godzinach działania programu).

Bawimy się z grupą już od 3 dni, i jeśli chcecie dołączyć – zapraszam:

👩👩👧👧 Grupa Facebookowa

📈 Leaderboard Vived (join code: 2276325-be92402e)

A żeby w jakiś sposób na zakończenie to połączyć z naszym głównym tematem… to bawiłem się dzisiaj ChatGPT i wiecie co? Robi to wrażenie.