Dzisiejsza edycja jest dosyć unikalna, ponieważ skupimy się na zapowiedziach z najnowszego Google IO. Szczególnie ciekawe rzeczy pokazano w kontekście AI, ale myślę że i pozostałe informacje Was zainteresują.

Zapraszamy do lektury!

Dzisiejsza edycja jest dosyć unikalna, ponieważ skupimy się na zapowiedziach z najnowszego Google IO. Szczególnie ciekawe rzeczy pokazano w kontekście AI, ale myślę że i pozostałe informacje Was zainteresują.

Zapraszamy do lektury!

Strasznie brakuje mi Google IO Extended – imprez towarzyszących corocznej konferencji Google dla deweloperów. Dlatego też w tym roku zdecydowaliśmy się wraz z kumplem, z którym zawsze na tego typu eventy chodziliśmy urządzić sobie własną imprezę z grillem i stream z Kalifornii. Miałem okazję oglądać zarówno główny Keynote, jak i Keynote dla programistów – a teraz mam okazję podzielić się z Wami co ciekawszymi ogłoszeniami.

Ktoś kiedyś powiedział (nawet szukałem, ale nie udało mi się dogrzebać do konkretnego cytatu), że dzisiejsze Google to firma, która nie jest oparta na wyszukiwarce, a na AI. Co prawda wyniki finansowe sugerują coś zupełnie innego, ale faktem jest, że to właśnie zwrot AI odmieniany był podczas Google IO w zasadzie przez wszystkie przypadki.

Wynika to z tego, że którego produktu od wielkiego G nie weźmiemy, możemy być pewni że w jakiś sposób pod spodem całość używa zaawansowanych modeli. Weźmy choćby właśnie wspomnianą wyszukiwarkę. Jedną z kluczowych zapowiedzi był Multitask Unified Model (w skrócie MUM). Jego rolą jest lepsze rozumienie prawdziwej intencji użytkownika. Rozwiązanie to oparte jest na podobnych badaniach co ogłoszony w 2019 roku algorytm BERT, Google chwali się jednak że jest od niego 1000x lepsze (co mnie, jako jednak ścisły umysł od, razu zastanawia co do czorta to znaczy). Google pochwaliło się podczas konferencji przykładem, gdy ktoś pyta wyszukiwarkę, jaki ma się przygotować na wyjazd na górę Fuji. W odpowiedzi dostał różnorodny zbiór informacji, od wytyczonej trasy, poprzez sugestie treningu fitness, na opcji zakupu różnorodnych biletów kończąc. Tym właśnie ma bowiem być MUM – modelem będącym w stanie podchodzić do tematu z wielu różnych perspektyw. Dodatkowo, model ma w dobry sposób radzić sobie z wieloma językami – może kiedyś doczekamy się tak złożonych zapytań również po polsku?

Drugim ciekawym modelem pokazanym podczas IO jest LaMda. Jest ona ponownie wynikiem prac nad rozwinięciem wspomnianego wcześniej BERTa, ale o ile MUM nacisk kładł w szczególności na wielokontekstowość, rolą LaMdy jest generowanie mocniej angażujących konwersacji z AI. Mają być one luźniejsze, przyjemniejsze i naturalne. Google podkreśla też, że nie ma zamiaru tutaj schlebiać gustom użytkowników, i model jest dodatkowo weryfikowany pod kątem zgodności faktograficznej udzielanych odpowiedzi, dla wielu osób więc rozmowa może być dość niekomfortowa. Ciekawe czy kiedykolwiek doczekamy się odpowiedzi choć zbliżonych do prezentowanych w języku polskim.

Oczywiście, wspomniane modele muszą być czymś napędzane. Tutaj również Google nie zawiodło, pokazując Tensor Processing Units (TPU) w wersji czwartej. Ponownie bawiąc się mnożnikami, nowe rozwiązania mają być dwukrotnie szybsze od poprzedników. Widać, że jeśli chodzi o ML, przyszłość należy do wyspecjalizowanych chipów tego typu – chyba wszyscy duzi gracze posiadają własne jednostki.

Oczywiście, nie są to jedyne rozwiązania powiązane z AI, które pokazane zostały podczas tegorocznego IO. Google pokazało np. narzędzia do rozpoznawania raka skóry za pomocą zwykłej kamery telefonu, a także np. lepsze algorytmy aparatu mające w bardziej inkluzywny sposób balansować kolory dla ludzi o odcieniu skóry innym niż kaukaski.

Jej, nowy Android! Ziew

A tak serio, to w porównaniu do choćby zeszłorocznej edycji, nowa choć odrobinę zaintrygowała mnie wprowadzeniem Material You – czyli nowego design systemu, tym razem jeszcze bardziej opartego na kolorach. Wprawdzie o “automatycznym doborze barw systemu w oparciu o Twoją tapetę” słyszę tak mniej więcej od Androida 5, ale jako że ostatnio wprowadzono wreszcie dobrze działający Dark Mode, możliwe że pod spodem doszło to odpowiedniego “refaktoringu”, który pozwoli wreszcie dobrze zadziałać tego rozwiązaniu. Oprócz tego słowo prywatność odmieniane było przez wszystkie przypadki i formy, prezentując choćby indykator włączonej kamery oraz mikrofonu czy też Android Private Computer Core – wbrew nazwie nie będący osobnym układem, a po prostu szczególnie chronioną przestrzenią na dane używane do ML, trochę w zbliżony sposób do tego jak robi się to z danymi biometrycznymi. Oprócz tego – jak zawsze poprawy szybkości i wydajności, a także pracy na baterii, bez których to nie może obyć się żadna premiera nowego telefonu.

Także w sumie rzeczywiście Ziew. Dobrze chociaż, że pojawiły się nowe narzędzia dla programistów, powoli min. Jetpack Composer UI wychodzi z Bety. Ale o tym pewnie wspomnimy już we wtorek przy okazji edycji JVMowej.

Znacznie ciekawiej prezentuje się sytuacja jeśli chodzi o zegarki. Przyznam, że zawsze takowy chciałem, zawsze też odrzucała mnie niedojrzałość tego gadżetu, przynajmniej w świecie Androida. Zawsze żałowałem, że raczej porządne Samsung Gear nie posiadały WearOS, przez co np. nie dało się nimi w żaden sposób płacić w Polsce. Stąd też zapowiedź połączenia WearOS z Tizenem wywołała we mnie pewien poziom ekscytacji. Zapowiedzi na samym Keynote były dosyć enigmatyczne, za to bardzo fajny materiał na temat “merdżu” przygotował Wired. Mam nadzieje, że już niedługo Apple Watch dostanie jakąkolwiek sensowną konkurencje. Co ciekawe, w ramach współpracy Samsung zapowiedział też przeportowanie Flutter SDK na Tizena – co jest dość ciekawe, biorąc pod uwagę, że teraz Tizen pozostanie w zasadzie jedynie częścią ich ekosystemu SmartTV.

Bonus: Wprawdzie nie Google IO, ale z poprzedniego tygodnia więc myślę że liczy się do tego podpunktu. Microsoft zapowiedział porzucenie Windows 10X, mającego być alternatywą dla Chrome OS. Biorąc pod uwagę jak swego czasu ważny był to dla Microsoftu projekt, opowieści zza kulis mogą być bardzo interesujące.

Co prawda, samo Google już zapowiedziało w grudniu, że raczej nie zamierza przechodzić na pracę w pełni zdalną (choć początkiem maja nieco złagodziło retorykę, twierdząc że może być to rozwiązanie dla ok. 20% pracowników), ale jednak zeszły rok dość mocno “namieszał” w naszym stosunku do pracy.

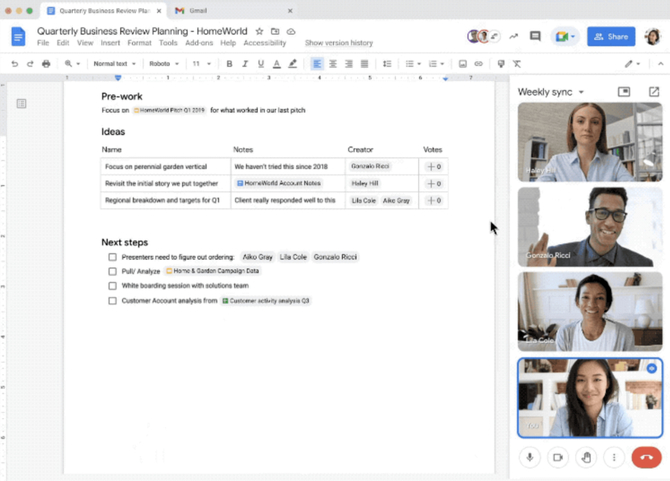

Podczas konferencji Google chwaliło się zmianami, które ich Google Meet otrzymał w zeszłym roku – choć w mojej ocenie dalej jest niesamowicie w tyle w stosunku do choćby Microsoft Teams, ze względu na fatalny chat tekstowy i brak dobrej integracji wszystkich Googlowskich usług. Jest szansa, że się to jednak niedługo zmieni – widać bowiem, że wielkie G mocno inwestuje w tą przestrzeń. Zapowiedzieli oni Smart Canvas dla Google Workspace – integracje Meeta, Google Docsów oraz Drive. Całość ma być dopalona możliwością wzajemnego linkowania poszczególnych zasobów w interaktywny sposób. Będąc szczerym, dalej wygląda mi to na rozwiązanie pośrednie, które jest efektem faktu, że Google nigdy nie dorobiło się własnego Slacka (może trzeba go było kupić), ale pokazuje to pewną inwestycje w lepszą integrację narzędzi.

Nie kłammy się jednak, największą rewolucją jeśli chodzi o pracę (i komunikację) zdalną był Project Starline. Google jest dobre w Moonshoty, a ichniejsze podejśćie do hmm… hologramów(?), robi niesamowite wrażenie. Zresztą, zobaczcie sami:

Prezentacja wygląda niesamowicie, a jeszcze bardziej cieszą mnie komentarze użytkowników którzy to rozwiązanie testowali. Na HackerNews znaleźć możemy masę wypowiedzi ludzi, którzy mieli okazję Starline testować i efekt ponoć wbija w fotel. Ciekawe, czy kiedykolwiek tego typu rozwiązania staną się realnym standardem.

To ogólnie nie był dobry tydzień – chyba, że dla frontendu. Dlatego też ludzi poszukujących nieco optymizmu odsyłam do naszej edycji czwartkowej.

I pamiętajcie, żeby spróbować Vived, jeśli chcesz otrzymywać tego typu treści spersonalizowane pod Ciebie!