🥳 Jesteśmy z Wami od roku! 🥳

Od 52 tygodni (nie zgubiliśmy po drodze ani jednego 🥰) informujemy Was o wszystkim, co dzieje się w świecie technologii. Postanowiliśmy z tej okazji trochę poświętować i podsumować ostatnie 12 miesięcy.

Skonsolidowanie wydarzeń proste nie było, potraktujcie ten przegląd jako bardzo „zopiniowany”. Mam jednak nadzieje, że będziecie się równie dobrze bawić czytając go, jak ja przy kompilowaniu całości.

Kluczowe trendy w świecie Technologii

GitHub Copilot to wierzchołek góry lodowej – współpraca Microsoftu i OpenAI jest znacznie szersza

Nie ma wątpliwości, że jednym z największych wydarzeń zeszłego roku była premiera GitHub Copilot.

Sojusz Microsoftu z OpenAI sprawił, że tysiące programistów zaczęło zadawać sobie jedno pytanie – czy to jest ten moment, kiedy maszyny zaczną pisać kod źródłowy i wysiudają nas z rynku?

Odpowiedzi na to pytanie zaczęły się klarować, im więcej wiedzieliśmy o modelu napędzającym Copilota. Codex (bo tak się nazywa) ma spore ograniczenia – efektywność modelu jest bowiem nie jest wprost proporcjonalna do rozmiaru danych testowych. Przy 300 milionach parametrów Codex rozwiązał w satysfakcjonujący sposób 13,2% problemów. Osiągnięcie wyniku dwa razy lepszego (28,8% skuteczności) wymagało już modelu składającego się 12-miliardów przykładów testowych – to prawie 159 gigabajtów kodu źródłowego(!). Jak łatwo się więc domyśleć, może się okazać więc, że nawet dostarczenie wszystkich dostępnych źródeł, jakie wygenerowała ludzkość nie pozwoli nam na osiągnięcie jakości kodu komercyjnego.

Pomimo tego, że to właśnie Copilot wystawił na świeczniki współpracę Microsoftu i OpenAI, ta zaczęła się znacznie wcześniej. Sztandarowy produkt OpenAI, model generowania tekstu GPT-3, licencjonowanyjest Microsoftowi na zasadach wyłączności. Obie firmy stworzyły też fundusz, zajmujący się poszukiwaniem młodych startupów potrafiących wykorzystać Data Science. W odróżnieniu od klasycznych VCs jego celem jest wyłapywać małe ilości firm, ale z jak największym potencjałem, zapewniając im maksymalny poziom wsparcia.

Czytaj więcej

- Software Craftsmanship Sunday vol. 39

- Software Craftsmanship Sunday vol. 44

- Software Craftsmanship Saturday vol. 45

- Software Craftsmanship Saturday vol. 51 – Codex API, NeuralHash, Dojo & D1

Microsoft „atakował” przestrzeń No-Code za pomocą Excela

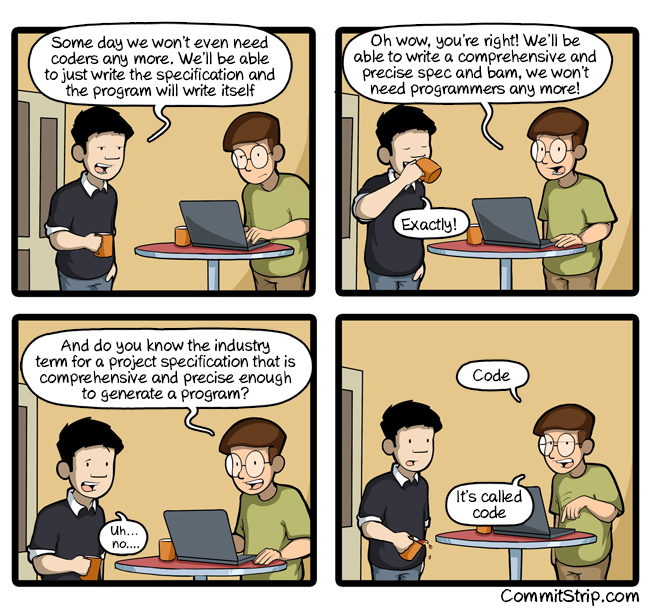

Intryguje mnie ewolucja kierunku w którym idzie No-Code, mam trochę flashbacki z Wietnamu którym było pojawienie się No-SQL – terminu którego rozwinięcie ewoluowało w kierunku “Not only SQL”.

No-Code przeszły prawie identyczny proces. Okazało się, że tak jak SQL jest jednak dość wygodnym i przemyślanym sposobem tworzenia zapytań od dane, tak kod to zaskakująco precyzyjny i użyteczny sposób reprezentacji logiki biznesowej. W ten sposób oryginalny No-Code powoli ewoluuje w kierunku Low-Code, co z mojej perspektywy wydaje się być dla niego dobrym kierunkiem – zwłaszcza gdy okazuje się, że odbiorcami tych narzędzi w dalszym ciągu pozostają specjaliści IT, chcący ułatwić sobie życie.

Firmom, która jednak chce wrzucić Low-Code w ręce mas jest Microsoftu, a chce to zrobić za pomocą… Excela. Nie dziwi mnie to nic a nic, bo sam widziałem w życiu arkusze które miały w sobie więcej

logiki niż niektóre pisane przeze mnie aplikacje komercyjne (tego się naprawdę nie da odzobaczyć 😱). Power Fx (bo o nim mowa) to próba stworzenia opartego na nim języka umożliwiającego wykorzystanie innych zasobów znajdujących się w zasobach firmowych, operacje na nich, a później stworzenie prostego interfejsu użytkownika.

Nie zaszkodzi również fakt, że ewolucje przeszedł sam Excel. Do tej pory miał on dwa duże ograniczenia – nie pozwalał na tworzenie własnych typów danych, oraz na tworzenie własnych funkcji. Microsoft Research Cambridge zmienił to, najpierw wprowadzając typy złożone oraz tablice, żeby w styczniu 2021 zrzucić na wszystkich hejterów arkuszy kalkulacyjnych bombę o nazwie LAMBDA. Jest to rozwinięcie języka funkcji Excela, używające klasycznej notacji Churcha do definiowania nowych funkcji.

Osobiście obserwuję trend Low-Code z dużym zainteresowaniem –

tak naprawdę życie jest za krótkie żeby w każdej kolejnej firmie pisać dokładnie ten sam “plumbing” czy kolejnego CRUDa. Mam jednak w pamięci jak skończyło się to ostatnim razem – już w latach 90tych pojawiały się w końcu rozwiązania typu IBM Harmony (mające zastąpić programistów), czy AbInitio (dające ludziom z biznesu możliwość “wyklikania” dataflowów). Może jednak czegoś się na tym nauczyliśmy i nowa generacja będzie po prostu lepsza.

Czytaj więcej

Hardware ZNOWU stało się interesujące

Ostatni rok zrobił coś, co wydawało się być niemożliwe – hardware (w tym konsumencki)

znowu stał się tematem dyskusji przy kawie! Myślałem, że te czasy już dawno minęły.

Zaskakująco, przyczyniło się do tego… Apple. Ich procesr M1 nie dość, że posiada niezwykle interesującą architekturę, to jeszcze okazał się być szybki oraz… napędzać relatywnie tanie (jak na Apple) maszyny. Apple jak zwykle poapplowało – jego rozwiązania to nie pierwsze komputery z procesorami ARM (takich prób było sporo), ale zdecydowanie są one diabelsko interesującym kawałkiem krzemu. Z pewnością jednym z powodów jest fakt, jak szybko wszyscy twórcy oprogramowania dopasowali się do nowej architektury – właściwie cały istotny software został doczekał się już portu na M1.

W ciągu ostatniego roku w zasadzie każdy większy gracz na rynku postanowił wejść w produkcję procesorów. Google posiada swoje TPU oraz procesory Argos dla Youtube, Amazon – Inferentie, Microsoft zaczął zaś używać rozwiązania dostarczonego przez GraphCore. Również na rynku komputerów domowych dzieje się ciekawie – o M1 już wspomnieliśmy, Microsoft również pracuje nad własnym chipem ARM, swojego Exynosa dla komputerów domowych niedawno pokazał też Samsung. Nad własnymi rozwiązaniami z dziedziny

procesorów pracować ma też ByteDance. Ostatnio zaś do wyścigu przystąpiła Tesla.

Wyspecjalizowane podzespoły są dopasowane do unikalnych potrzeb rozwiązań, które będą napędzać. Przez to mają być zarówno szybsze, jak i wydajniejsze energetyczne – a więc i posiadać mniejszy świat węglowy. Jest się na pewno z czego cieszyć, ale w tej całej beczce miodu jest z mojej perspektywy dość duża łyżka dziegciu. W technologicznym rynku i tak mocno zmierzającym w kierunku oligopolu, niedługo może się okazać, że aby konkurować z dużymi graczami, niezbędny będzie nie tylko pomysł, know-how techniczny i światowej klasy zespół, ale również własny hardware. Każde ogłoszenie o nowym, super wydajnym procesorze, to nie tylko cios w jeszcze niedawną dominację Intela, ale również fosa utrudniająca wejście na rynek potencjalnej konkurencji.

Dodatkowo, 2021 przejdzie do historii jako rok potężnych braków na rynku podzespołów. Nie ma nowych konsol, nie ma kart graficznych… nie ma również procesorów.

I to nie tylko dla tak zwanej elektroniki konsumenckiej, ale również dla przemysłu, co może mieć dalekosiężne konsekwencje. Przykładowo, brakuje podzespołów do produkcji… samochodów. W wyniku problemów, największe firmy technologiczne świata zaczęły lobbować w rzędzie USA o subsydia dla producentów komponentów – tak zwany CHIPS for America Act ma przeznaczyć 50 miliardów dolarów publicznych pieniędzy na zwiększenie mocy produkcyjnych amerykańskich producentów.

Czytaj więcej

- Software Craftsmanship Saturday vol. 33

- Software Craftsmanship Saturday vol. 37

- Software Craftsmanship Sunday vol. 39

- Software Craftsmanship Saturday vol. 40

- Software Craftsmanship Sunday vol. 44

IPFS stał się istotniejszym elementem internetu

IPFS to rozwinięcie od The InterPlanetary File System. Nazwa brzmi buńczucznie, ale w zasadzie dobrze oddaje założenia tego protokołu – jest to zbudowany na zasadzie Peer-to-Peer odpowiednik takiego Rapidshare czy Megaupload. Ma on dwie główne zalety: konsystentne adresowanie (każdy umieszczony plik ma swój identyfikator pozwalający na jego znalezienie w ramach sieci) oraz zdecentralizowanie

– wspomniany już plik z unikalnym identyfikatorem może równocześnie znajdować się w wielu miejscach naraz. Efektem jest fakt, że bardzo trudnym staje się usunięcie raz umieszczonych tam materiałów. Wykorzystała to min. Katalonia podczas organizacji referendum mającego na celu odłączenie się od Hiszpanii.

Przeglądanie stron udostępnionych poprzez IPFS wymagało jednak w dalszym ciągu sporej wiedzy, przez co było to do niedawna rozwiązanie przeznaczone wyłącznie dla bardziej zaawansowanych

technicznie użytkowników. Przeglądarka Brave jako pierwsza mainstreamowa przeglądarka (a w zasadzie druga, po mobilnej Operze) zdecydowała się jednak udostępnić dostęp do stron opartych na IPFSx out-of-the-box. Próg wejścia do zasobów tam umieszczonych staje się więc o wiele niższy.

Jednak do całości układanki brakowało jeszcze jednego elementu. Obecne linki w sieci IPFS wyglądają następująco: ipfs://QmXoypizjW3WknFiJnKLwHCnL72vedxjQkDDP1mXWo6uco , ponieważ adres każdego zasobu jest wygenerowanym “hashem” jego kontentu. To tak jakby przeglądać normalną sieć po adresach IP. I mimo że adresy IP są o wiele krótsze i składają się tylko z cyfr, to chyba nikt nie chciałby surfować po internecie przy ich użyciu. Problem ten został rozwiązany za pomocą Domain Name Systemu, popularnego DNSa. DNS jest jednak systemem opartym na wielu warstwach cache (przez co wolny) oraz całkowicie scentralizowanym (przez co łatwym w cenzurze).

Rozwiązanie które proponują researcherzy z Cloudflare, opiera się na sieci Ethereum. EthLink, bo tak się nazywa,

jest Proxy dla IPFS pozwalającym przechowywać na Ethereum sygnaturę zawartości danego adresu. Worker uruchamiający EthLink (będący Cloudflare Workerem, ale również dowolnym rozwiązaniem lokalnym) może zaś tą sygnaturę własnoręcznie zweryfikować, potwierdzając że nikt nie naruszył integralności zwracanej strony.

Rozwiązanie to przybliża nas do w pełni zdecentralizowanej sieci, a także pokazuje że Ethereum to nie tylko zabawka służąca do hodowania wirtualnych kotów (aczkolwiek o hodowli kotów jeszcze wspomnimy)

Czytaj więcej

Czym do diabła są NFT?

Teraz będzie zabawnie.

Po paru latach nie istnienia w świadomości “normalsów”, Blockchainy w w 2021 roku uderzyły ze zdwojoną siłą. Sam w temacie siedzę od dłuższego czasu i nieco śmiałem się z przewidywań, że pewnego dnia Bitcoin będzie wart 100 000 dolarów. Już się wcale nie śmieje (waluacja to prawie 50k$, a była już ponad 60k$ 😵).

Podobnie sytuacja ma się z NFT. Kiedy w 2017 roku pojawiła się pierwsza “killer-app”

na Ethereum, okazało się, że mesjaszem „światowego komputera” mają być cyfrowe, dziwne koty. Reagowałem na to ze swoistym rozbawieniem, a moim dość ironicznym stosunkiem do tematu dzieliłem się już z Wami w jednej z poprzednich edycji naszych sobót. Nagle przychodzi marzec, a NFT stają się najbardziej dyskutowanym tematem roku 🙀.

Dobra, ale pora chyba rozwinąć termin NFT. Jest to akronim od wyrażenia Non-Fungible Tokens. Jeżeli porównanym dwa Bitcoiny, są one nie do odróżnienia od siebie. Mogą być one być stosowane całkowicie zamienne – tak właśnie należy rozumieć słowo “fungible”. Jest to jedna z cech waluty, dość podobnie sprawa wygląda np. z banknotami 10 dolarowymi. Jeżeli jednak z jakiegoś powodu chcemy posiadać bardzo konkretny, wykopany “token” (np. wykopany 20 Marca o godzinie 06:54), wtedy dany token jest określany niewymienny (Non-Fungible) – posiada dodatkową wartość sam w sobie.

Tak było z Kryptokotkami, tak było z Kryptopunkami, i ogólnie przez lata temat co pewien czas przebija się

do świadomości ludzi. Jak widzicie jednak na zaprezentowanym wyżej wykresie, nigdy jeszcze dyskusja nie wezbrała do poziomu z Marca tego roku. Katalizatorem stała się sprzedaż oryginalnego Nyan-Cata, a później kolekcji dzieł artystki Grimes których to dziesięć zostało zakupione za 6 milionów dolarów.

Jednak nikt chyba nie spodziewał się tego co wydarzyło się potem. Dzieło “NFT – 5000 days”, cyfrowy plik jpg który każdy może pobrać i skopiować (a raczej powiązany z nim Token własnościowy), został sprzedany na aukcji za 69 milionów $, stając się trzecim najdroższym dziełem sztuki w historii. Temat do tej pory się ciągnie, i wszystko wygląda na to, że NFT nie będą tylko przelotną modą, a zostaną z nami na dłużej.

Krytpowaluty ogólnie nie były stabilnym rynkiem – nie tylko Grimes miała na niego taki wpływ. Również jej partner, Elon Musk bawił się nimi jak prywatnym folwarkiem, pojedynczymi tweetami drastycznie zmieniając kurs poszczególnych walut 😉 Za to „on the long run” – jeśli rok temu dokupiłeś Ethereum – trochę zazdrość.

Czytaj więcej

- Software Craftsmanship Saturday vol. 24

- Software Craftsmanship Saturday vol. 29

- Software Craftsmanship Saturday vol. 35

- Software Craftsmanship Saturday vol. 50

Zainstaluj teraz i czytaj tylko dobre teksty!

Tym żył świat (IT)

Inwigilacja – Spadek zaufania do IT

System Pegasus nie służy tylko do podsłuchiwania terrorystów? Kto by się spodziewał 🤷♂️

Takiej “inby” jeśli chodzi o tematy związane ze śledzeniem obywateli nie było od czasu, gdy w 2013 roku Edward Snowden wyjawił tajniki programu PRISM (tak, od tamtej pory minęło już prawie 10 lat). Od tamtego czasu wprawdzie takie firmy jak Palantir czy wspominany dzisiaj Pegasus pojawiały się w mediach (min. w kontekście zakupu ich usług przez Polski rząd), jednak chyba nigdy jeszcze sprawa nie była tak “gruba”. W ramach śledztwa Amnesty International udało się ustalić ponad 50 tys. ofiar Pegasusa, oprogramowania działającego jak spyware i w założeniach służącego do walki z terroryzmem. Wyciek udowodnił, że narzędzie nie jest wykorzystywane tylko do walki z terrorystami, ale że rządy w wielu krajach używają go również do śledzenia nie tylko aktywistów, dziennikarzy czy prawników, ale w niektórych przypadkach również ich rodzin.

Co najśmieszniejsze, mimo że od afery minęły dopiero 3 tygodnie – świat chyba już trochę… zapomniał? Mam jednak wrażenie, że akurat echo całej sytuacji zostają w nas dłużej. Przekonało się o tym Apple, gdy zapowiedziało, iż będzie skanowało urządzenia użytkowników pod kątem zdjęć o charakterze pedofilskim.

Będąc adwokatem diabła 😈: podejście Apple (czyli dokonywanie całego procesu lokalnie) ma pewne nieoczywiste zalety. W dyskursie publicznym (a przede wszystkim legislacyjnym) coraz więcej mówi się o tym, jak to pełna enkrypcja danych nie pozwala (w dobie komunikacji przez internet) na odpowiednią ochronę obywateli – niedawno zresztą świat obiegła informacja, że służby bezpieczeństwa w celu rozbicia grupy przestępczej stworzyły własną aplikacje komunikacyjną, która posłużyła jako tak zwany “garniec miodu”.

W pokrętny sposób wybija więc w ten sposób służbom argumenty których można by użyć w celu wymuszenia na Apple zaniechania takiego szyfrowania. Dzięki temu dane trzymane w chmurze nie będą więc dostępne dla osób trzecich. Mimo wszystko mleko się rozlało, w czym na pewno nie pomogły wcześniejsze kontrowersje jak np. te związane z Pegasusem. Zapowiedziane zmiany

spotkały się z krytyką zarówno wśród pracowników (uważajacych, że firma może stracić opinii podmiotu przykładającego szczególną uwagę do prywatności klientów) jak i szerokiego grona użytkowników (twierdzących, że to tylko pierwszy krok do szerszej inwigilacji – najłatwiej takie zmiany wprowadza się pod sztandarem walki z pedofilią)

Czytaj więcej

- Software Craftsmanship Saturday vol. 47

- Software Craftsmanship Saturday vol. 50

- Software Craftsmanship Saturday vol. 51

Wyzwania Diversity & Inclusion dla branży – Google, Free Software Foundation, Basecamp

Prywatność, a bezpieczeństwo to problem natury etycznej – a z takimi łatwiej mierzyć się, bez pobywania jednej z liderek firmowego działu Etyki AI, prawda Google? Firma dokładnie to bowiem zrobiła z Timnit Gebru, współzałożycielką Black in AI.

Z pragmatycznego puntu widzenia nie ma się co dziwić. Timnit współstworzyła bowiem publikację otwarcie krytykującą tworzenie olbrzymich modeli językowych,

stanowiących “chlebek i masełko” Google, napędzając najbardziej innowacyjne rozwiązania firmy. Gebru w dokumencie zarzuca tworzonym przez firmę modelom MLowym min. olbrzymi ślad węglowy czy “betonowanie” języka poprzez opieranie się w większości na danych historycznych. Google odbija piłeczkę, zarzucają zespołowi Timnit nienaukowość i pisanie “pod tezę”. Cała sprawa odbiła się jednak szerokim echem w społeczności w końcówce zeszłego roku i była motorem do powstania w Google związku zawodowego programistów. Twitter szybko zalany został komentarzami mówiącymi o “13tkach” i “wczasach pod gruszą, jednak jest to lekkie minięcie się z tematem. Celem organizacji nie jest walka o benefity, a o szeroko rozumianą etykę pracy – brak wspierania konfliktów zbrojnych, równość szans dla pracowników z niedoreprezentowanych grup, “demokratyzację” modeli uczenia maszynowego.

Kolejnym dużym wydarzeniem w tematyce był powrót Richarda Stallman do Free Software Foundation, z której odszedł w atmosferze skandalu. W 2019 roku, w ramach prywatnej korespondencji, wstawił się on za długoletnim przyjacielem, Marvinem Minskym, zaangażowanym w głośną aferę Jeffreya Epsteina. W swojej wiadomości twierdził, że jego kolega nie miał pojęcia,

że 17-latka z którą utrzymywał kontakty seksualne była do nich przymuszana, nie powinno się więc traktować go jako stręczyciela. Korespondencja wyciekła, a sam Stallman został przez opinie publiczną zmuszony do odejścia z rolii prezesa FSF, ale także z uczelni MIT. W połowie marca tego roku, Stallman wrócił do Free Software Foundation jako członek zarządu. Spowodowało to odejście sponsorów (Red Hata), a także kilku ważnych członków zarządu fudacji.

Ostatnim głośnym incydentem była zaś decyzja Jasona Fried – CEO Basecampu – wprowadził… zakaz rozmów dotyczących spraw politycznych i społecznych w firmowych kanałach komunikacyjnych, będąa reakcją na pewne kontrowersji, które pojawiły się wewnątrz firmy, J. W często przywoływanej wypowiedzi stwierdził on, że o ile wrażliwość społeczna jest ważna, o tyle naprawa świata nie jest celem istnienia Basecampu – ludzie powinni wykorzystywać podczas pracy energię nie na polityczne spory, a na tworzenie najlepszego możliwego oprogramowania dla klientów.

Basecamp nie jest tutaj prekursorem

(końcówką poprzedniego roku na podobny ruch zdecydował się Coinbase). Mamy jednak do czynienia z firmą, która stworzyła niejedną publikację o tym jak poukładana jest u nich praca – w związku z tym też jest znacznie bardziej “na świeczniku”. Dość dobrze znane są efekty decyzji – z firmy (z różnych powodów) zwolniła się ok. jedna trzecia załogi (co brzmi dość szokująco, ale początkiem kwietnia w Basecampie pracowało tylko 57 osób), w wyniku kontrowersyjnej metody obrony decyzji zarządu odszedł też Ryan Singer – autor wspomnianego „Shape Up” i Head of Strategy firmy.

Co ciekawe, Jason Fried po czasie udzielił wywiadu Samowi Harrisowi, w którym nawet znając konsekwencje dalej broni on swojej decyzji.

Disclaimer – wszystkie tematy potraktowane zostały skrótowo. Po więcej detali (i mój szerszy komentarz) zapraszam do poniższych linków.

Czytaj więcej

- Software Craftsmanship Saturday vol. 31

- Software Craftsmanship Saturday vol. 36

- Konflikt w Googlowskim dziale Etyki AI. Jego liderka odchodzi z firmy.

Polityka USA przeciekała do projektów IT

Wszyscy życzyliśmy sobie spokojnego 2021 – a ten zaczął się z przytupem. Przede wszystkim w USA, gdzie polityka zaczyna odciskać swoje piętno na to w jaki sposób działa tamtejsza branża technologiczna, co może mieć interesujące reperkusje również dla Europy.

Po wydarzeniach z okupowaniem Kongresu w styczniu (pewnie każdemu obiło się o 👂) zarówno Twitter, jaki Facebook postanowiły… zbanować konta ówczesnego prezydenta Stanów Zjednoczonych, Donalda Trumpa, początkowo do końca jego kadencji, ostatecznie skończyło się pernamentnym banem. Interesujący precedens, który dla jednych jest oznaką cenzury i czymś niedopuszczalnym, dla reszty uzasadnionym działaniem.

Po współczesnym Alamo (jakim stanie się zapewne “Atak na Kapitol”) zaczęły się łowy na jego prowodyrów. Biją tam, gdzie zaboli najbardziej. Odbywa się to poprzez miększe działania, jak np. moderacja i obcinanie zasięgów. Efekt nie był spektakularny, ponieważ większość tak zwanej alt-prawicy przeniosło się na Parlera. Parler to platforma społecznościowa. Taka, która swoją unikalną niszą biznesową postanowiła uczynić przestrzeń do wyrażania opinii skutkujących na Twitterze czy Facebooku natychmiastowym banem. Amazon użył wtedy “opcji atomowej ⚛️”, bo nie wiem jak inaczej nazwać danie 24h na migracje z chmury (jako dział IT Parlela chyba bym rzucił wypowiedzeniem zaraz po ukazaniu się takiego nagłówka do prasy). Parler zdołał się odrodzić, dzięki “niezależnemu” hostingowi

dostarczonemy przez SkySilk Cloud, firmę z siedzibą w Los Angeles (a nie żadne rosyjskie, jak próbowano przez chwilę wmówić). Parler stracił jednak pazur i zmienił przy okazji wytyczne dla społeczności – teraz treści z groźbami, nawoływaniem do przemocy oraz materiałami pornograficznymi będą ściślej moderowane zarówno przez przygotowany do tego algorytm, jak i zwykłych moderatorów.

A jak już jesteśmy przy Stanach – warto wspomnieć o zmianach w procesie przyznawania Zielonej Karty – informację bardzo ciekawą z punktu widzenia wszystkich, którzy chcieli kiedyś wyjechać do Doliny Krzemowej.

Obecny system imigracyjny uniemożliwia w danym roku wymusza, aby nie więcej niż 7% wniosków o tak zwaną “zieloną kartę” przyjmowane było z pojedynczego kraju. Z jednej strony, powoduje to dość dobre rozłożenie poszczególnych nacji, z drugiej sprawia, że gęsto zaludnione kraje (jak Indie czy Chiny) szybko uderzały w limity. Eagle Act, o którym piszemy zniesie ten limit i podniesie górny limit zielonych kart dla pojedynczego kraju z 7% do 15%. Z naszej perspektywy zmiana wydaje się niekorzystna – potencjalnie nawet 30% wszystkich miejsc może zajęte zostać tylko przez dwa wyżej wspomniane Indie i Chiny, o więcej niż miliardowej populacji. Znalazłem statystyki mówiące o tym, że Polacy i tak stanowili tylko ok. 2% wszystkich przyjmowanych – podniesienie limitu nie ma dla nas większych bonusów.

Czytaj więcej

Regulacje technologii od każdej strony

Wiemy już co się działa w Stanach, czas przyglądnąć się reszcie świata. Jeżeli Firmy technologiczne miałoby opublikować na Facebooku swój status związku z rządami państw pewnie wybrałyby “to skomplikowane”.

Relacjonowanie dla Was tego konfliktu bywa dosyć zabawne, ale ten cały 🍿, którym się przy tym obżeram odbija mi się czkawką (i nadmiernymi kilogramami).

Zacznijmy od antypodów. Australia, podobnie jak inne kraje na świecie (w tym Polska), chce wyciągnąć trochę pieniędzy od internetowych graczy. Jej strategia to tak zwany “podatek od linkowania”. Ma on zmusić firmy technologiczne do płacenia za treści informacyjne na ich platformach (aczkolwiek nie tylko, bo np. również do dzielenia się z firmami medialnymi szczegółami swoich algorytmów). Przykładowo, Google, mimo początkowej “napinki”, że wycofa się z Australii, ostatecznie podwinęło ogon i dogadało się z rządem australijskim. Ciekawsza była jednak decyzja Facebooka – pokazał on “cojones” i zdecydował się zablokować w Australii wszystkie newsy, zarówno te krajowe, jak i z reszty świata.

Decyzja wywołała olbrzymie kontrowersje, pojawiły się głosy że jest to próba monopolistycznego wpłynięcia na politykę krajową przez wielkie konsorcjum na niespotykaną wcześniej skalę. Ostatecznie doszło do kompromisu, firma Marka Zuckeberga i rząd dogadały się (po pewnych poprawkach do ustawy). Na początku sierpnia Facebook ogłosił Newsroom Sustainability Fund, który ma wesprzeć dziennikarstwo w Australii.

Lećmy dalej – przechodzimy do Europy. O sprawach antymonopolowych nie ma co się tutaj rozpisywać – szkoda miejsca. Ale również prawodawstwo jest ciekawe.

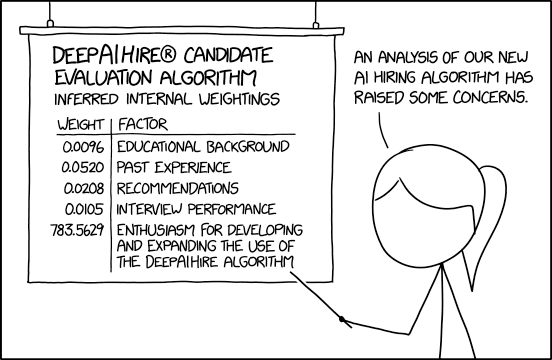

W połowie kwietnia ukazała się propozycja rozporządzenia o znamiennej nazwie Artificial Intelligence Act. Jest to efekt wielomiesięcznych prac, a całość ma stanowić podwaliny pod uczynienie Unii Europejskiej liderem w zakresie rozwoju bezpiecznej i godnej zaufania sztucznej inteligencji. Co ciekawe, celem dokumentu jest promocja użycia sztucznej inteligencji. Unia zauważa problem związany z rosnącym strachem przed możliwościami systemów informatycznych, zarówno pod względem ingerencji w prywatność, jak i możliwość profilowania i represjonowania poszczególnych grup (niech przykładem będzie tutaj system Huawei mający na celu wyłuskiwać z tłumu ludzi o konkretnej etniczności). Problem ten zamierza rozwiązać w swój ulubiony sposób – regulując rynek. Na szczególnym celowniku znalazły się

użycia w medycynie, rekrutacji czy też system porządkowy lub sądowniczy. Wymagane ma być również “zrozumiałość” poszczególnych modeli i możliwość wprowadzenia ludzkiego nadzoru.

Skończymy na Chinach. Przez długie lata, branża technologiczna była swoistym “pieszczochem” chińskiej władzy. To właśnie ichniejsze firmy takie jak Xiaomi, Alibaba czy TikTok byly istotnym motorem wzrostu gospodarczego, ale również sposobem na zyskanie czegoś, co specjaliści od geopolityki nazywają “soft power” – swoistym “rozmiękczaniem” wizerunku i możliwości wywierania wpływu na opinie publiczną na świecie. Stanowiły więc istotną siłę w budowaniu nowoczesnych, mocarstwowych Chin.

Okazuje się, że również tam powoli „dziki zachód” zaczyna się kończyć. Ostra zmian kursu rozpoczęła się w październiku ubiegłego roku, kiedy chiński miliarder Jack Ma, założyciel Alibaby, skrytykował Chiny za brak uczciwie funkcjonującego systemu finansowego. Od pierwszego maja aplikacje w Chinach nie mogą już zbierać nadmiarowych danych, będą też musiały potrafić się wytłumaczyć z celu trackowania użytkownika. Oficjalnie jest to motywowane dbaniem o obywateli i ich dobro, niektórzy wskazują jednak na fakt, że nawet chińskie władze przestraszyły się potęgi swoich gigantów IT i zaczyna szerokie działania w celu ukrócenia ich działań.

Czytaj więcej

- Software Craftsmanship Saturday vol. 25

- Software Craftsmanship Saturday vol. 30

- Software Craftsmanship Saturday vol. 36

- Software Craftsmanship Saturday vol. 43

- Software Craftsmanship Saturday vol. 50

Breaking Changes – najbardziej zaskakujące ogłoszenia

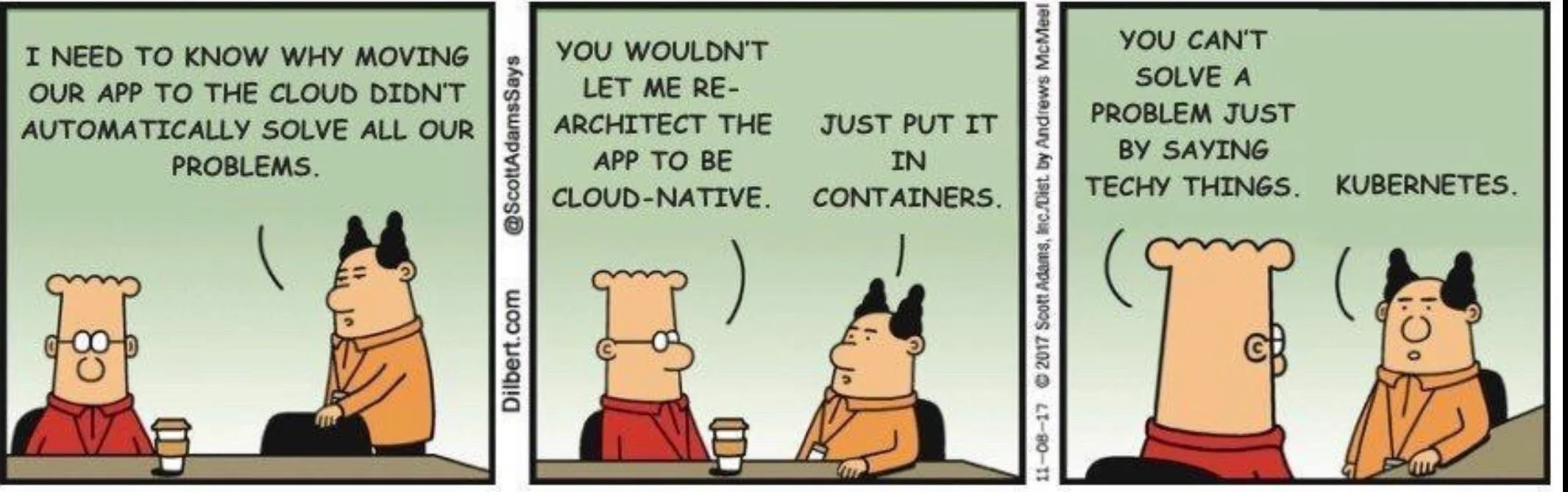

Kubernetes rezygnuje z Dockera

Zaraz na początku grudnia, światem konteneryzacji wstrząsnęła bardzo niepokojąca nowina – Kubernetes porzuca wsparcie dla Dockera. Na programistów padł blady strach – mimo pojawienia się masy alternatyw, to jednak Docker w świadomości ludzi pozostaje głównym środowiskiem do tworzenia kontenerów. Do dyskusji szybko włączyli się twórcy Kubernetesa, nie tylko tłumacząc się z decyzji, ale też uspokajając, że zmiany nie są tak daleko idące jak na pierwszy rzut oka się wydaje.

Zarówno Kubernetes, jak i Docker (a także każde inne narzędzie działające z kontenerami) posiada środowisko uruchomieniowe, pozwalające na wykonywanie dostarczonych obrazów. Kubernetes przez lata wspierało zarówno swój standard (CRI-O) jak i Dockerowy (containerd). Problem polega na tym, że Docker jest rozwiązaniem przeznaczonym do obsługi przez człowieka, przez co posiada sporo nadmiarowych funkcjonalności. Do tej pory Kubernetes je emulowało, wraz z wersją 1.20 rozpoczął się proces ich porzucania.

Mamy zatem bardzo dobry przykład tego, jak zbawienną rzeczą są standardy. Docker może pozostać narzędziem używanym w developmencie lokalnym, zaś na Kubernetesie wygenerowane obrazy będą uruchamiane po prostu na ich własnym runtime.

RedHat rezygnuje z rozwoju CentOS na rzecz CentOS Stream

Pozostając w tematyce DevOpsowej, tym razem smutna nowina – przyszło nam pożegnać jeden z najważniejszych systemów operacyjnych używanych przez administracyjną brać.

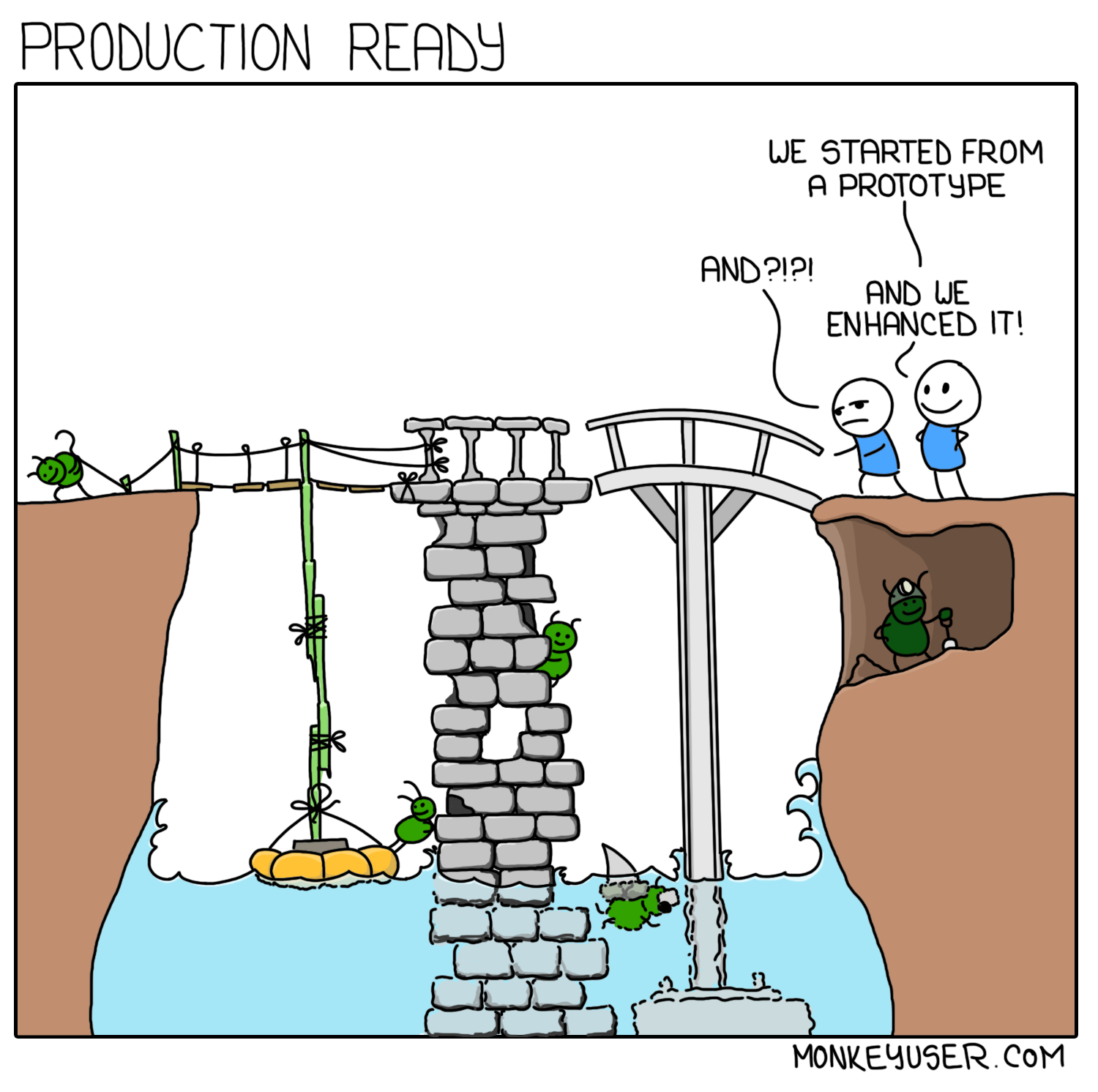

CentOS (Community Enterprise Linux Operating System) był projektem założonym w 2004, którego głównym celem (zgodnie z nazwą) było zapewnienie darmowego, stabilnego systemu operacyjnego – co przez wiele lat osiągane było to poprzez przebudowywanie źródeł Red Hata – bardzo popularnego rozwiązania komercyjnego. CentOS w początkowych latach radził sobie na tyle skutecznie, że udało mu się zdobyć miano najpopularniejszej serwerowej dystrybucji Linuxa. Niestety, ze względu na tarcia we własnym community stracił na wiarygodności, a kontrolę nad projektem przejął wspomniany już Red Hat. Przez wiele lat wszystko było po staremu, niestety parę dni temu na community gruchnęła wiadomość o tym, że dalszy rozwój CentOS zostaje porzucony na rzecz CentOS Stream.

Czym jest CentOS Stream? Zamiast systemu z długim, 10-letnim wsparciem, będziemy mieli do czynienia z dystrybucją z kategorii “bleeding edge” – nowa wersja co roku, każdorazowo z supportem do następnego wydania. Gołym okiem widać, że jest to de facto zaprzeczenie oryginalnych założeń projektu – w środowisku produkcyjnym najważniejsza jest stabilność. Właściwie ciężko wskazać dla kogo jest CentOS Stream – zwłaszcza że już istnieje działająca na bardzo podobnych zasadach Fedora.

Amazon vs ElasticSearch

Początkiem roku, ElasticSearch poinformował o zmianach licencji projektu na SSPL. Licencja ta uniemożliwia twórcom chmur obliczeniowych łatwego brania kodu projektów OS, opakowywania go własnym brandem i sprzedawania (wcześniej podobną drogą poszło MongoDB, które jest zresztą twórcą SSPL). Ruch ten wywołał małe trzęsienie ziemi wśród użytkowników ElasticSearcha – o ile sam cel można uznać za słuszną walkę Dawida z Goliatem, o tyle zapisy licencji w niektórych miejscach są mocno kontrowersyjne. Wskazują ona np. na konieczność udostępnienia kodu aplikacji internetowych używających ElasticaSearcha. Całość pełna jest ogólników, co z jednej strony pozwala twórcom popularnej Kibany na ochronę swojego interesu, z drugiej zaś tylko zwiększa niepewność społeczności.

Bardzo ciekawym zwrotem akcji całej sytuacji był z pewnością moment kiedy to Amazon zdecydował się sforkować ElasticSearcha. Rzeczony fork ukazał się w kwietniu, udostępniając otwarte (w rozumieniu – oparte na licencji Apache) OpenSearch (oparte na Elasticsearch 7.10.2) oraz OpenSearch Dashboards (oparte o zbudowany na Elasticsearchu dashboard Kibana 7.10.2). Nie mogę pozbyć się wrażenia, że Amazon celowo dał w nazwie nowych projektów Open, żeby zagrać na nosie Elasticowi.

Projekt rozwijany ma być przez społeczność, a oprócz Amazona w projekt zaangażowane są Red Hat, SAP, Capital One, oraz Logz.io. Wszystkie usługi w ramach AWS zostaną oparte właśnie o tą dystrybucję i przejdą stosowny rebranding.

Ostatnie tygodnie przynoszą kolejne uderzenie. ElasticSearch zmienił kodo swojego klienta Pythonowego (elasticsearch-py) w taki sposób, by ten nie był w stanie się łączyć do klastrów OpenSearcha. Oczywiście, spotkało się to z falą niezadowolenia i krytyki. Elastic argumentuje, że Amazon OpenSearch to inny produkt – a choć istnieje jakaś wspólna historia, już istnieje wiele różnic, które powodują prawdziwe zamieszanie i problemy. Nie można odmówić tej argumentacji sensu, ale raczej nie stawia Elastica w pozytywnym świetle

Dodatkowo, warto przypomnieć, że na bardzo podobny ruch do tego ElasticSearch parę lat temu zdecydowało się MongoDB. Raczej tego nie żałują – od czasu swojej kontrowersyjnej decyzji ich wartość giełdowa podwoiła się.

Czytaj więcej

- Software Craftsmanship Saturday vol. 20

- Software Craftsmanship Saturday vol. 21

- Software Craftsmanship Saturday vol. 33

Kafka pozbywa się Zookeepera 🐒

Jak w temacie. Wydana w kwietniu Kafka 2.8.0 udostępniła preview długooczekiwanego KIP-500 – usunięcie Zookeepera.

Apache ZooKeeper to komponent zapewniający dystrybucję konfiguracji oraz konsensus, używany w wielu projekt, gdzie wymagana jest wysokiej dostępność – za przykład niech posłuży np. Solr czy Spark. Jest to też niezbędny element każdego kafkowego klastra – Apache Kafka trzyma w Zookeeper metadane o topicach, borkerach, czy też consumerach. O ile jest to dość wygodne z punktu widzenia Confluenta – mogą oni używać sprawdzonego w boju, “wygrzanego” rozwiązania – o tyle dla administratorów jest to kolejny ruchomy klocek, wprowadzający spory narzut operacyjny. Dlatego też, czując na karku oddech konkurencji i chcąc ułatwić życie użytkownikom, Kafka wprowadza swoją własną wersję „konsensusu”, opartą na Raftcie. Zamiast na zewnętrznym komponencie, ma opierać się na wewnętrznym topicu o dość deskryptywnej nazwie @metadata.

Czytaj więcej

Zainstaluj teraz i czytaj tylko dobre teksty!

My Darlings – czyli Trivia

Złamano rekord wykonania “Problemu Komiwojażera”

Ze wszystkich problemów pochodzących z teorii obliczeń, “komiwojażer” jest chyba tym, który w największym stopniu przebił się do masowej świadomości programistów. Pomysł na najbardziej “złą” rozmowę rekrutacyjną: zaprezentować go komuś do rozwiązania i obserwować czy od razu ochoczo rzuci się na IDE. Absolutnie nie polecamy (trafia się za to do jeszcze głębszego kręgu piekieł niż za “coding task” w Javie na kartce papieru), aczkolwiek efekty mogłyby być interesujące.

Dlaczego jednak przywołujemy problem, który podobno poprzedza powstanie pierwszych komputerów o prawie sto lat? Otóż po 44 latach teoretyczna granica rozwiązania została przesunięta. Nowa metoda jest 2 * 10^36 lepsza od poprzedniej ustalonej – przygotowując dla nich ten krótki opis, sprawdzałem kilkukrotnie czy na pewno się nie pomyliłem z liczbą.

Dzielimy się tym jednak z Wami nie z powodu zachwytu nad rozmiarem skoku, jaki udało się nam osiągnąć, a dlatego że poprzednia najlepsza metoda efektywnie wyszukiwała ścieżki, będące w najgorszym przypadku dłuższe od rozwiązania optymalnego o równiutkie 50%. Zejście poniżej 50%, nawet jeśli jedynie o wartości tak minimalne, przemawia do wyobraźni i przebija pewną “barierę mentalną” zbudowaną wokół tego słynnego problemu. Nie będę jednak ukrywał, że sama wartość spowodował uśmiech na mojej twarzy.

Nowa Metoda SEARCH zaproponowana jako rozwinięcie HTTP 🔍

Propozycja dodania nowej metody w HTTP to nie jest mała rzecz – ostatni raz coś takiego wydarzyło się wraz z opublikowanie HTTP/1.1 w roku 1999, ponad 20 lat temu. Dlatego też informacja o opublikowaniu przez IETF – Internet Engineering Task Force – proposala dotyczącego dodania do protokołu (obok dobrze znanych metod pokroju GETa i POSTa, czy też mniej znanych TRACE i CONNECT) metody SEARCH z pewnością jest dużym wydarzeniem. Wydarzeniem bliskim memu sercu ponieważ wielokrotnie przy pracy z RESTowymi API musiałem obchodzić ograniczenia HTTP – ograniczenia, które SEARCH ma zniwelować.

SEARCH można rozumieć jako formę GETa posiadającego również “ciało”. Całość przydatna będzie nie tylko w opisanym przeze mnie powyżej przypadku, ale również jako standardowy protokół transferowy dla zdobywającego coraz większą popularność GraphQL – jego twórcy już ostrzą sobie zęby na jego użycie.

Czytaj więcej

The Reactive Principles – Design Principles for Distributed Applications

Na koniec prawdziwa kobyła – Reaktywne Pryncypia, przewodnik zredagowany przez Jonasa Bonéra (CTO Lightbend), do którego przyłożyły się takie uznane nazwiska jak Roland Kuhn czy Ben Christensen. Stanowi on swego rodzaju rozwinięcie mającego już parę lat Reactive Manifesto, które dość mocno wpływnęło na postrzeganie przez branże IT czym jest nowoczesna architekta.

Jeżeli miałbym się posłużyć tutaj prostą analogią, to Reaktywne Pryncypia są tym dla Reaktywnego Manifestu czym “Czerwona” książka DDD Vaughna jest dla dla tej “Niebieskiej” Reisa – zbiorem praktycznych porad pomagających wdrożyć teoretyczne założenia. Polecam to kompendium każdemu do ciepłej kawy/herbaty w jakiś leniwy wieczór – oczywiście jeśli architektury rozproszone są “waszą rzeczą”.

Pamiętajcie, żeby spróbować Vived, jeśli chcesz otrzymywać tego typu treści spersonalizowane pod Ciebie!