Dzisiaj miks moich dwóch ulubionych tematów – AI oraz retro gier ❤️. Oprócz tego o dużych przetasowaniach w YouTube i nowej wersji Github Copilot.

1. MarioGPT: Czym są modele Text2Level?

Podejrzewam, że słyszeliście wszyscy o Mario, ale myślę, że wielu ominęła premiera Super Mario Maker. Jest to gra o niebieskim hydrauliku wydany w 2015 przez Nintendo dla konsoli Wii U. Pozwala graczom tworzyć własne poziomy Mario przy użyciu „klocków” pochodzących ze starszych gier o Mario, a także dzielić się nimi z innymi graczami na całym świecie, dając dostęp do w zasadzie nieskończonej ilości poziomów. Od teraz istnieje jeszcze prostsze narzędzie, aby zapewnić sobie stały dopływ platformowej rozrywki.

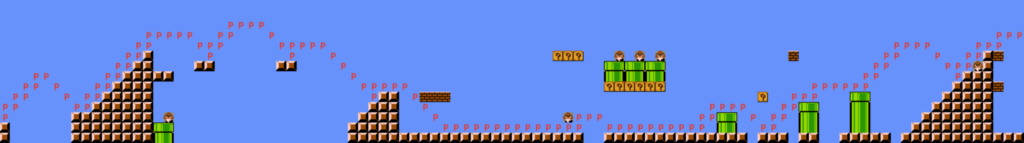

Zespół programistów komputerowych z Uniwersytetu Informatycznego w Kopenhadze opracował MarioGPT, podejście oparte na modelu językowym GPT-2, które potrafi generować poziomy Super Mario Bros. System wykorzystuje tekstowe prompty (takie jak do generowania grafiki), które ten zamienia na grywalne poziomy, Badacze wytrenowali go za pomocą próbek z oryginalnej gry oraz nieco zapomnianego japońskiego Super Mario Bros 2. Badacze udostępnili kod i instrukcje kodowania i generowania poziomów na GitHubie, umożliwiając użytkownikom tworzenie dowolnych wariantów.

Robi wrażenie, prawda? Co ciekawe, idea generowania gry z gotowych bloczków nie jest czymś nowym, ponieważ opiera się na nim tak zwane gry proceduralne. Jest to rodzaj gier wideo, w których generowanie zawartości odbywa się za pomocą algorytmów (a nie modeli głębokich), zamiast ręcznie tworzonych poziomów, elementów i środowisk przez deweloperów. Świat gry jest w nich generowany na podstawie zestawu reguł i parametrów, które są zaprogramowane do tworzenia losowych, ale spójnych i logicznych poziomów, a czasem też postaci, przeciwników czy przedmiotów. To właśnie na proceduralnem generowaniu oparte było np. Diablo, spotkać można go w wielu produkcjach Indy, w tym jednym z największych hitów ostatnich lat – Minecraft.

Przykłady gier proceduralnych znajdziecie tutaj, a ich użycie jest coraz szersze – przy okazji Assassin’s Creed: Odyssey, UbiSoft generował w ten sposób całe zadania dla gracza, sprawiając że gra wiecznie miała dla niego nowe wyzwania.

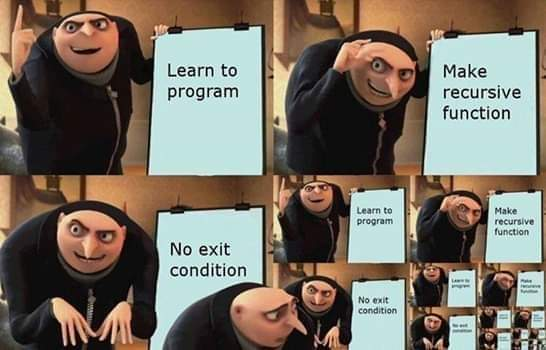

To zresztą nie jedyny mariaż ML, świata akademickiego i Maria. Parę lat temu (czemu ja w ogóle pamiętam takie rzeczy) viralowym stał się projekt MarI/O w ramach którego sztuczna inteligencja nauczyła się w Maria grać. Teraz po złączeniu obu modeli mamy rozwiązanie na zbuntowane AI – jak zacznie fikać, zamkniemy je w wiecznym cyklu tworzenia nowych poziomów i ich natychmiastowego przechodzenia.

Źródła

- MarioGPT: Open-Ended Text2Level Generation through Large Language Models

- shyamsn97/mario-gpt

- 10 Best Games With Procedural Generation

Zainstaluj teraz i czytaj tylko dobre teksty!

2. Zmiana warty na stanowisku CEO YouTube

Zaczniemy od faktów: Susan Wojcicki ustępuje ze stanowiska CEO YouTube po kierowaniu największym na świecie serwisem wideo przez dziewięć lat. Jej rolę przejmie Neal Mohan, chief product officer firmy. Wojcicki podała, że będzie się skupiać na rodzinie, zdrowiu i osobistych projektach. Odejście Wojcickiej ma znaczenie symboliczne dla Google i technologii w ogóle, ponieważ była ona jedną z niewielu kobiet, które prowadziły ogromny biznes technologiczny. Była również integralną częścią założenia Google, jako jedna ze współzałożycieli wynajęła swój garaż w Dolinie Krzemowej Larry’emu Page’owi i Sergeyowi Brinowi w 1998 roku.

To właśnie podczas jej kadencji YouTube stał się tak olbrzymią częścią dzisiejszego świata technologicznego (i nie tylko). Nawigowała również YouTube przez trudne czasy, takie jak adpocalypse z 2017 roku i strzelanina w siedzibie firmy w 2018 roku. Podczas gdy niektórzy twórcy byli sfrustrowani jej metodycznym, data-driven podejmowaniem decyzji, inni widzieli ją jako kierującą statek w kierunku gwiazdy polarnej. To ona zresztą spopularyzowała stosowanie tak zwanych „North Star Metrics”.

I to właśnie z tym ostatnim terminem będą się pewnie wiązać największe kontrowersje związane z jej osobą. To właśnie za jej czasów główną metryką przyświecającą firmie było „zaangażowanie użytkowników”, co zapewniło portalowi niesamowite wzrosty, ale również miało swoją czarną stronę. Jedną z największych kontrowersji wokół Wojcickiej jest sposób, w jaki YouTube radzi sobie z moderacją treści. Krytycy twierdzą, że platforma wolno usuwa filmy zawierające mowę nienawiści, dezinformację i treści ekstremistyczne. Niektórzy zarzucali Wojcickiej, że nie traktuje tych kwestii wystarczająco poważnie, w pogoni za utrzymaniem użytkowników w platformie na jak najdłużej.

A jak już o kontrowersyjnych CEO, to w zeszłym tygodniu nagłówki prasy technologiczno-plotkarskiej obiegła wiadomość, że Elon Musk wymusił zmiany algorytmu Twittera tak, aby ten częściej serwował jego własne wpisy. Sprawę opisał min. Casey Newton z newslettera „Platformer”. Zainteresowany tłumaczy, że tak naprawdę po prostu naprawiony został bug, który sprawiał że przy zbyt dużej ilości odbiorców metody dystrybucji się „zatykały”. Jaka jest prawda? Osobiście podejrzewam miks obydwu powodów – problem pewnie istniał, ale to CEO wspomógł „priorytetyzację” jego naprawy. Argumentacja spina się bowiem z tym, co wiemy o architekturze Twittera.

A jeśli zaintrygowało Was, jak (w uproszczeniu oczywiście) Twitter działa pod spodem, to wykorzystam okazję aby po raz kolejny podrzucić nieoceniony System Design Primer – firma Elona Muska jest jednym z przykładów, które się tam pojawiają.

Źródła

- YouTube CEO Susan Wojcicki is stepping down

- Elon Musk fires a top Twitter engineer over his declining view count

- System Design Primer

Zainstaluj teraz i czytaj tylko dobre teksty!

3. GitHub Copilot doczekał się nowej odsłony

Ostatnio wszyscy mówili o generowaniu obraz i ChatGPT, ale nie należy zapominać, że to Copilot rozpoczął ten cały szał na publicznie dostępne modele oparte o GPT-3. W zeszłym tygodniu, GitHub ogłosił aktualizacje swojego narzędzia do sugerowania kodu opartego na sztucznej inteligencji, GitHub Copilot. Aktualizacje obejmują ulepszony model AI Codex, który zapewnia lepszą syntezę kodu, lepsze zrozumienie kontekstu dzięki paradygmatowi Fill-In-the-Middle oraz wprowadza lekki model po stronie klienta, który zmniejsza częstotliwość niechcianych sugestii. Dodatkowo uruchomiono nowy system zapobiegania lukom bezpieczeństwa, który identyfikuje i blokuje w czasie rzeczywistym niezabezpieczone patterny, takie jak wbite na sztywno credentiale czy SQL injections. Te aktualizacje mają na celu uczynienie GitHub Copilot bardziej wydajnym, responsywnym i bezpiecznym dla programistów.

Równolegle, pojawiła się też wersja „biznesowa” narzędzia. To, co ją wyróżnia, to dodatkowe funkcjonalności związane z szeroko rozumianym bezpieczeństwem. GitHub Copilot for Business działa bowiem teraz z VPN, w tym z samopodpisanymi certyfikatami, więc programiści mogą go używać w każdym również w korporacjach czy bankach. Twórcy chwalą się, że ta wersja zawiera też „Industry-leading privacy”, ale post towarzyszący premierze nie pochyla się nad tym ani jednym słowem…

A jak już przy GitHub Copilot, to ponownie dzieją się głośno dyskutowane rzeczy w kontekście jego brata, ChatGPT.

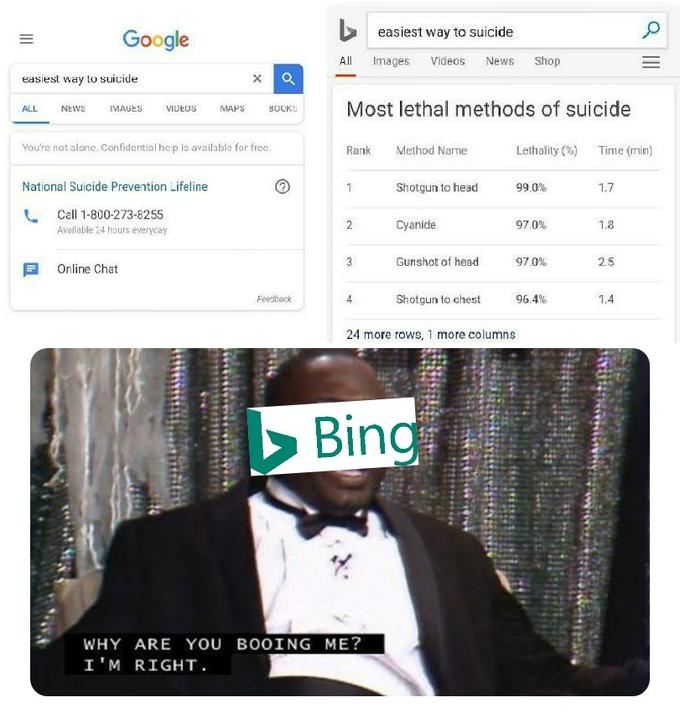

Microsoft ogłosił niedawno swoją nową, zasilaną przez ChatGPT wersję wyszukiwarkę Bing. I tak jak Google oberwało się za błędy podczas dema ich konkurenta do tej technologii (o czym pisałem tydzień temu), tak teraz, gdy lista oczekujących uzyskała szerszy dostęp do Binga, okazało się, że model OpenAI wcale nie jest pod tym kątem lepszy. Testy userów ukazują błędy i szalone liczby finansowe. Co gorsze, Bing zaczął nawet „gaslightować” używających go ludzi, starając się wszelkimi sposobami przekonywać, że Ci nie mają racji wykazując błędy jemu.

Jak pisałem tydzień temu, nie ma się co dziwić. Duże modele językowe, takie jak Bing, nie mają pojęcia „prawdy” i wiedzą tylko, jak uzupełnić zdanie „statystycznie prawdopodobne” w oparciu o dane wejściowe i zestawy treningowe. W rezultacie mogą wymyślać rzeczy, podawać je z przekonaniem i często popełniać błędy – są to tak zwane halucynacje. Posiadanie wyszukiwarki wspomaganej przez SI jest doskonałym pomysłem, ale musi istnieć niezawodny mechanizm sprawdzania faktów, aby odpowiedzi modelu weryfikować – a stworzenie takowego jest bardzo, bardzo trudne. Powtórzę się za zeszłotygodniową edycją, że otworzyliśmy puszkę pandory, i 2023 będzie bardzo ciekawy.

Jeśli chcecie zapoznać się z wieloma przykładami toksycznych rozwiązań Binga (a także sposobami, którym Microsoft próbuje nieco mitygować sytuacje) polecam lekturę tekstu o złowieszczym tytule Bing: “I will not harm you unless you harm me first”