Tydzień temu nie mieliśmy naszego przeglądu (występowałem na konferencji Boiling Frogs i po prostu brakło mi czasu), więc teraz za karę cierpię – pojawiło się bowiem tak wiele materiału, że aż nie wiedziałem, na które tematy się zdecydować. Stwierdziłem więc, że zrobię… kalendarium.

1. Co ciekawego w Wielkich Modelach – Kalendarium

Wystarczy że dwa tygodnie mnie nie było, a tutaj 🤯.

Dlatego teraz w formie kalendarium, przejdziemy sobie przez najważniejsze wydarzenia mniej więcej od początku marca… i wyjdzie nam z tego zaskakująco długa sekcja.

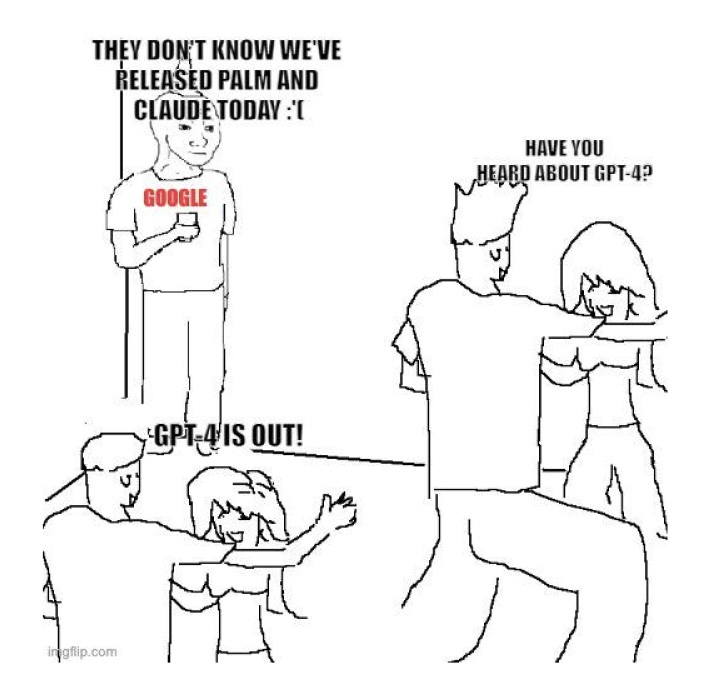

10.03.2023 – Google pokazuje PALM-E

Google uruchomił interfejs API dla jednego ze swoich najbardziej zaawansowanych modeli językowych, PaLM, który jest podobny do GPT lub modeli LLaMA Meta. PaLM może wykonywać wiele zadań generowania i edycji tekstu, od pisania kodu po generowanie podsumowań lub nawet szkolenie konwersacyjnych chatbotów.

Oprócz interfejsu API PaLM, Google opublikował aplikację o nazwie MakerSuite, która ułatwia programistom szkolenie PaLM do wykonywania konkretnych zadań, umożliwiając im iterowanie po zachętach i uzupełnianie zbiorów danych syntetycznymi danymi. Google rozszerzył również wsparcie dla AI generatywnej w swojej platformie Vertex AI oraz uruchomił nową platformę o nazwie Generative AI App Builder, która pozwala programistom szybko tworzyć nowe aplikacja wzbogacone o AI, takie jak boty, asystenci cyfrowi i niestandardowe silniki wyszukiwania, korzystając z dostępu do API podstawowych modeli Google’a i gotowych szablonów. Funkcje związane z PALM-E trafią też do Google Workspace.

14.03.2023 – GPT-4

O PALM-E wszyscy zapomnieli jednak niecały tydzień później, ponieważ OpenAI pokazało GPT-4. Model ma być bardziej kreatywny i współpracujący niż kiedykolwiek wcześniej oraz może rozwiązywać trudne problemy z większą dokładnością. Umie też przetwarzać zarówno wejścia tekstowe, jak i obrazy, choć na razie może odpowiadać tylko tekstem. OpenAI nawiązało też współpracę z firmami takimi jak Duolingo, Stripe i Khan Academy, aby zintegrować GPT-4 z ich produktami. Co jednak najważniejsze, każdy jest w stanie testować model w ramach ChatGPT Plus, miesięcznej subskrypcji za 20 dolarów.

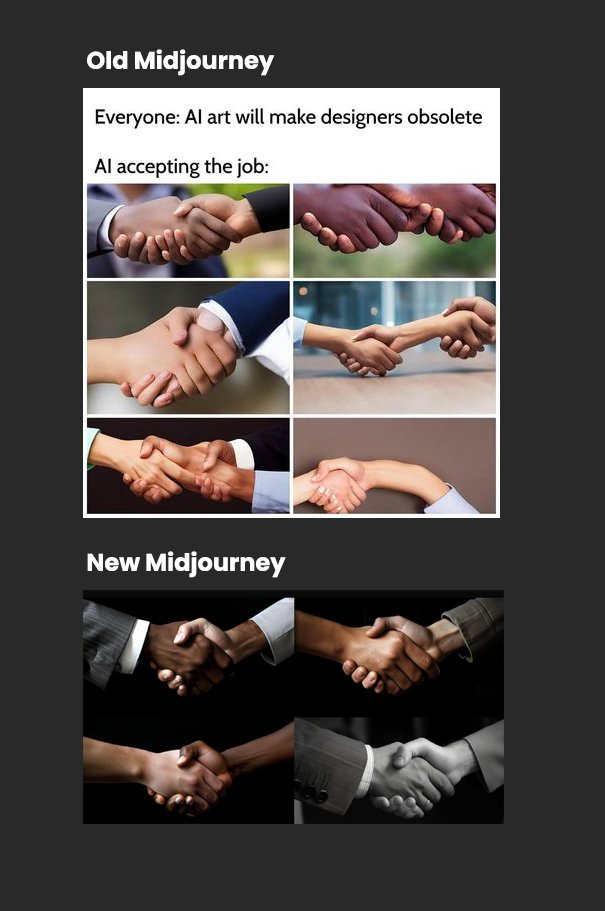

15.03.2023 – MidJourney v5

Zaledwie dzień po premierze GPT-4, w nasze ręce wpadła nowa wersja mojego ukochanego Midjourney V5. Oferuje ona wyższą jakość obrazu, bardziej zróżnicowany zakres stylów i „bezszwowe” tekstury. Potrafi też generować bardziej realistyczne obrazy rąk i oczu, a według doniesień jest bardziej precyzyjna i responsywna na prompta użytkowników. Niektórzy opisali wyniki jako fotorealistyczne i „niezwykle fascynujące”, ale inni są zaniepokojeni efektem „doliny niepewności” i możliwością generowania fałszywych obrazów, które mogłyby przejść za autentyczne.

Założyciel Midjourney ostrzega, że nowa wersja może generować bardziej realistyczne obrazy niż jakakolwiek poprzednia wersja i zwiększył liczbę moderatorów, aby egzekwować standardy społeczności z większą surowością i rygorystycznością.

16.03.2023 – Microsoft 365 Copilot

Zaledwie dzień później, Microsoft ogłosił kolejne narzędzie, Microsoft 365 Copilot. Oprogramowanie łączy w sobie modele OpenAI z danymi Microsoft Graph i aplikacjami Microsoft 365, tworząc narzędzie produktywności, które odpowiada na naturalne zapytania językowe. Copilot oferuje trzy podstawowe korzyści: pomaga oszczędzić czas, działając jako prompt do pisania lub tworzenia prezentacji; zwiększa produktywność poprzez podsumowywanie e-maili i generowanie sugerowanych odpowiedzi. Copilot będzie dostępny w programach Word, Excel, PowerPoint, Outlook, Teams, Power Platform, Viva i innych, a wprowadzenie go nastąpi w ciągu kolejnych miesięcy.

21.03.2023 – Google Bard dostępny publicznie

Bard od Google wreszcie został udostępniony publicznie jako Preview w Stanach Zjednoczonych i Wielkiej Brytanii. Użytkownicy mogą zadawać do niego ogólne pytania i otrzymywać porady, choć Google podkreśla, że nie jest to zastępstwo dla jego wyszukiwarki.

W odróżnieni od Chatbota dostępnego w Bingu, Bard nie skanuje stron internetowych, a używa wyłącznie bazy swojego modelu. Bardzo ciekawe porównanie możliwości trzech narzędzi przygotował The Verge w tekście AI chatbots compared: Bard vs. Bing vs. ChatGPT

22.03.2023 – GitHub Copilot X

GitHub ogłosił GitHub Copilot X. Nowe zmiany to dodanie interfejsu czatu, GitHub Copilot Chat, zintegrowany z edytorem, zdolny do dostarczania dogłębnej analizy i wyjaśnień bloków kodu, generowania testów jednostkowych, a nawet proponowania naprawy błędów.

GitHub Copilot X zawiera również Copilot dla Pull Requestów, który wykorzystuje nowy model OpenAI GPT-4 do generowania opisów dla pull requestów, a także Copilot dla dokumentacji.

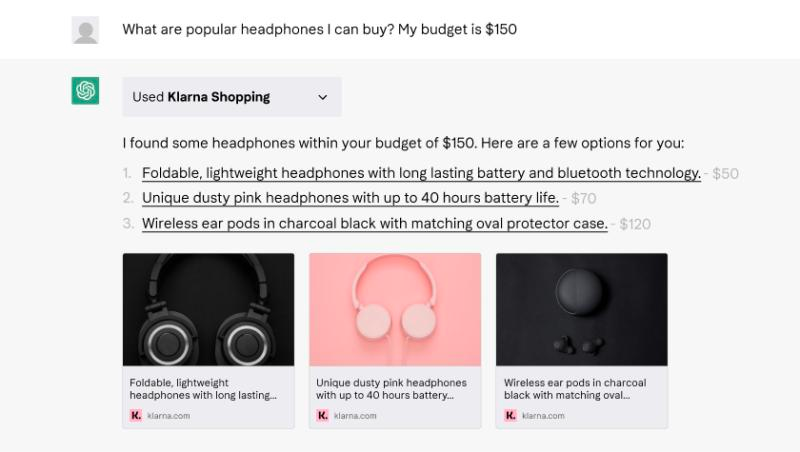

23.03.2023 Wtyczki do ChatGPT

ChatGPT zapowiedział wdrożenie Pluginów. Umożliwiają one łączenie ChatGPT z zewnętrznymi aplikacjami. Pierwszy zestaw wtyczek został stworzony przez developerów z min. Expedia, FiscalNote, Instacart, KAYAK, Klarna, Milo, OpenTable, Shopify, Slack, Speak, Wolfram i Zapier. Wtyczki te będą stopniowo udostępniane dla małej grupy deweloperów i użytkowników ChatGPT Plus.

Kalendarium mamy z głowy… Ale na tym jeszcze nie koniec.

Zainstaluj teraz i czytaj tylko dobre teksty!

2. Wszyscy piszą o AI

Największym dowodem, że AI wchodzi do mainstreamu to fakt, że każdy chce mieć na jego temat opinie. Ostatnio seminarne teksty w temacie opublikowało pare ważnych osobistości, dlatego czuje się w obowiązku je przytoczyć

Zacznijmy od sporej dawki optymizmu w wykonaniu nikogo innego niż Bill Gates. W swoim tekście The Age of AI has begun opisuje, że w jego życiu tak naprawdę miały miejsce dwie rewolucyjne według niego zmiany technologiczne. Pierwszą było wprowadzenie interfejsu graficznego użytkownika, który umożliwił stworzenie nowoczesnych systemów operacyjnych jak Windows. Drugą natomiast obserwujemy teraz – jest to rozwój sztucznej inteligencji modelu GPT stworzonego przez OpenAI, który zdobył najlepszy wynik na egzaminie z biologii na poziomie Advanced Placement. Gates uważa, że rozwój sztucznej inteligencji jest równie fundamentalny jak stworzenie mikroprocesora, komputera osobistego, internetu i telefonu komórkowego i zmieni sposób, w jaki ludzie pracują, uczą się, podróżują, otrzymują opiekę zdrowotną i komunikują się ze sobą.

Yuval Noah Harari, autor „Sapiens”, w swoim tekście You Can Have the Blue Pill or the Red Pill, and We’re Out of Blue Pills martwi się zaś potencjalnymi ryzykami związanymi z sztuczną inteligencją (A.I.), zwłaszcza z dużymi modelami językowymi, takimi jak GPT-4. Argumentuje, że systemy A.I. powinny być poddawane testom bezpieczeństwa i wprowadzane do społeczeństwa w tempie, które pozwala kulturze bezpiecznie je wchłonąć. Harari obawia się, że A.I. mogłoby szybko pochłonąć i manipulować kulturę ludzką, prowadząc do świata, w którym nieludzka inteligencja kształtuje historie, melodie, prawa i narzędzia. Ostrzega przy tym, że A.I. mogłoby zamknąć ludzkość w świecie iluzji podobnym do Matrixa, bez strzelania do nikogo ani wszczepiania chipów w mózgi. Harari nawołuje więc liderów światowych do ulepszania instytucji i nauki opanowania A.I. przed tym, jak ona nas opanuje, abyśmy mogli zrealizować obiecane korzyści A.I., unikając potencjalnych zagrożeń.

A na koniec, żeby położyć wisienkę na torcie – w trakcie pisania tego tekstu pojawił się odcinek podcastu Lexa Friedmana, do którego ten niezwykle popularny host zaprosił Sama Altmana – CEO OpenAI. Jeszcze całości nie miałem okazji przesłuchać (wywiad ma dwie i pół godziny), ale już nie mogę się doczekać.

Zainstaluj teraz i czytaj tylko dobre teksty!

3. Kontrowersje (i nowe funkcjonalności) u Docker

Żeby nieco zmienić wątek, na koniec będzie o Dockerze.

W zeszłym tygodniu Docker wywołał zamieszanie w społeczności open source, ogłaszając, że kończy subskrypcje Free Team. Krytycy odczytali to jako „płać lub stracisz swoje dane”, ale Docker szybko się zreflektował – przeprosił i twierdził, że zmiana nie oznaczała żadnych nikczemnych planów wobec projektów open source, aby zmusić je do płacenia.

Firma argumentowała, że tier Free Team jest używany dla różnych rodzajów klientów i użytkowników, ale nie służył żadnemu z nich szczególnie dobrze. Docker starał się wypchnąć klientów z tego poziomu, ale nie w celu zmuszenia projektów open source do płacenia 420 dolarów rocznie. Ideą miała być konwersja projektów open source na sponsoringowany program open source, który oferuje lepsze korzyści niż poziom Free Team, takie jak brak limitów stawek, poprawiona widoczność na Docker Hub i lepsza analiza danych.

Jednakże po „otrzymaniu opinii i konsultacjach z społecznością” Docker zdecydował się cofnąć swoją decyzję o zaprzestaniu planu Free Team. Klienci na planie Free Team nie muszą już przenosić się na inny plan przed 14 kwietnia, a klienci, którzy ulepszali swoje subskrypcje między 14 marca a dzisiejszym ogłoszeniem, otrzymają pełny zwrot pieniędzy. Klienci, którzy zdecydowali się na migrację na plan Personal lub Pro, pozostaną na swoim obecnym planie Free Team lub mogą otworzyć nowe konto za pośrednictwem strony internetowej. Docker zachęca także projekty open source do składania wniosków do programu Docker-Sponsored Open Source (DSOS).

Trzeba oddać jednak Dockerowi, że ostatni tydzień przyniósł nie tylko kontrowersje związane z rodzajami subskrypcji. Nawiązał on bowiem partnerstwo z Ambassador Labs, aby uprościć rozwijanie i testowanie Kubernetes dzięki Telepresence for Docker. Opcja ta pozwala deweloperom na korzystanie z Telepresence w połączeniu z narzędziami Docker, łącząc lokalne maszyny deweloperskie z zdalnymi klastrami dev i staging na Kubernetes. Ta metoda umożliwia programistom na łatwe iterowanie kodu lokalnie, testowanie skutków tych zmian w kontekście rozproszonej aplikacji oraz efektywną współpracę.

Telepresence dla Docker działa przez uruchomienie poda zarządzającego ruchem sieciowym w Kubernetes oraz deamonów klientów Telepresence na stacjach roboczych deweloperów. Zarządzający ruchem sieciowym działa jako dwukierunkowy proxy sieciowe, przechwytując połączenia i kierując ruch między klastrem a kontenerami działającymi na maszynach deweloperów.